پیشینه و مروری بر روشهای مختلف یادگیری عمیق ( با محوریت Computer vision )

بسم الله الرحمن الرحیم

مطالب زیر یکی از بهترین reviewهای ۲۰۱۵/۲۰۱۶ هست که من البته بعضی جاها رو دست زدم (یعنی اطلاعات بیشتری رو اضافه کردم برای کار خودم .تو ورژن مربوط به خودم RNN ها رو هم اضافه کرده بودم که ناقص بود برای همین برش داشتم تا کامل بشه و بعد احتمالا تو یه پست جداگانه بزارم . دقت کنید این review همه روشهای فعلی در یادگیری عمیق رو پوشش نمیده. از این بعنوان یکی از منابع استفاده کنید نه تنها منبع خودتون ).

اینم عیدی ما برای عید فطر 🙂

۱-۱- مقدمه

الگوریتم های یادگیری عمیق[۱] زیرمجموعه ای از الگوریتم های یادگیری ماشین هستند که هدف آنها کشف چندین سطح از بازنمودهای (نمایش)های توزیع شده[۲] از داده ورودی است. اخیرا الگوریتم های یادگیری عمیق زیادی برای حل مسائل هوش مصنوعی سنتی ارائه شده اند. در این بخش ما مروری بر بعضی از الگوریتم های به روز این مبحث در حوزه بینایی کامپیوتر خواهیم داشت. در ابتدا خلاصه ای از چندین روش یادگیری عمیق متفاوت و پیشرفت های اخیر آنها ارائه میکنیم و سپس بصورت خلاصه کاربردهای هر یک را در زمینه های مختلف بینایی [۳] همانند دسته بندی تصاویر,[۴] شناسایی اشیاء[۵], استخراج تصاویر[۶], قطعه بندی معنایی[۷] و برآورد ژست انسان[۸] توضیح میدهیم. در انتهای این بخش نیز گرایشات و مشکلات آینده در طراحی و آموزش شبکه های عصبی عمیق بصورت خلاصه ارائه میشود. .

۱-۲- روش ها و پیشرفت های اخیر

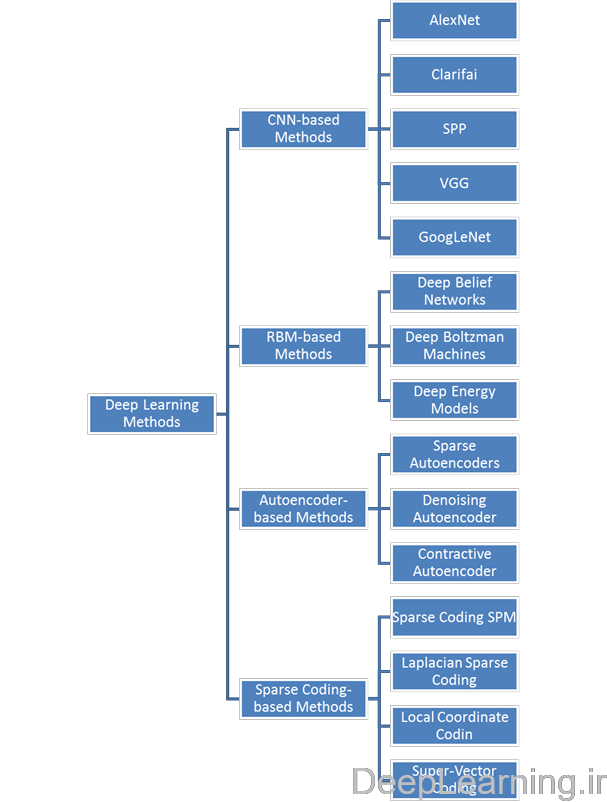

طی سالهای اخیر, یادگیری عمیق بصورت گسترده در حوزه بینایی کامپیوتر مورد مطالعه قرار گرفته است و به همین دلیل, تعداد زیادی از روش های مرتبط با آن بوجود آمده است.. بطور کلی, این روشها بر اساس روش پایه ای که از آن مشتق شده اند به ۴ دسته مختلف تقسیم میشوند که عبارتند از Convolutional neural networks , Restricted Boltzmann Machines (RBMS) , Autoencoders و در آخر Sparse Coding .

دسته بندی روش های یادگیری عمیق را به همراه کارهای انجام شده با هر یک از این روشها در شکل ۱ مشاهده میکنید .

- دسته بندی روش های یادگیری عمیق به همراه چند نمونه از کارهایی انجام شده با هر کدام

۱-۲-۱-Convolutional Neural Neworks (CNNs)

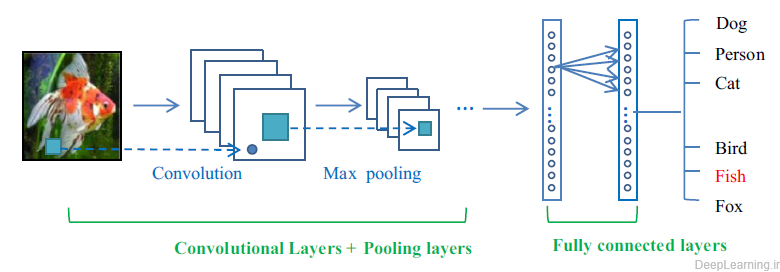

شبکه های عصبی کانولوشن (CNN) یکی از مهمترین روش های یادگیری عمیق هستند که در آنها چندین لایه با روشی قدرتمند آموزش میبینند(۲۰) این روش بسیار کارآمد بوده و یکی از رایجترین روشها در کاربردهای مختلف بینایی کامپیوتر است. تصویر کلی یک معماری شبکه عصبی کانولوشن در شکل ۲ نمایش داده شده است . بطور کلی, یک شبکه CNN از سه لایه اصلی تشکیل میشود که عبارتند از : لایه کانولوشن, لایه Pooling و لایه تماما متصل. لایه های مختلف وظایف مختلفی را انجام میدهد. در شکل ۲ یک معماری کلی از شبکه عصبی کانولوشن برای دسته بندی تصاویر (۲۱) بصورت لایه به لایه نمایش داده شده است .در هر شبکه عصبی کانولوشن دو مرحله برای آموزش وجود دارد. مرحله feed forward و مرحله backpropagation یا پس انتشار .در مرحله اول تصویر ورودی به شبکه تغذیه میشود و این عمل چیزی جز ضرب نقطه ای بین ورودی و پارامترهای هر نورون و نهایتا اعمال عملیات کانولوشن در هر لایه نیست. سپس خروجی شبکه محاسبه میشود. در این جا به منظور تنظیم پارامترهای شبکه و یا به عبارت دیگر همان آموزش شبکه, از نتیجه خروجی جهت محاسبه میزان خطای شبکه استفاده میشود. برای اینکار خروجی شبکه را با استفاده از یک تابع خطا (loss function) با پاسخ صحیح مقایسه کرده و اینطور میزان خطا محاسبه میشود. در مرحله بعدی بر اساس میزان خطای محاسبه شده مرحله backpropagation آغاز میشود. در این مرحله گرادیانت هر پارامتر با توجه به قائده chain rule محاسبه میشود و تمامی پارامترها با توجه به تاثیری که بر خطای ایجاد شده در شبکه دارند تغییر پیدا میکنند. بعد از بروز آوری شدن پارامترها مرحله بعدی feed-forward شروع میشود. بعد از تکرار تعداد مناسبی از این مراحل آموزش شبکه پایان میابد.

انواع لایه های شبکه CNN

در حالت کلی, یک شبکه عصبی کانولوشن یک شبکه عصبی سلسله مراتبی است که لایه های کانولوشنی آن بصورت یک در میان با لایه های pooling بوده و بعد از آنها تعدادی لایه تماما متصل وجود دارد .

- یک طرح کلی از معماری یک شبکه عصبی کانولوشن

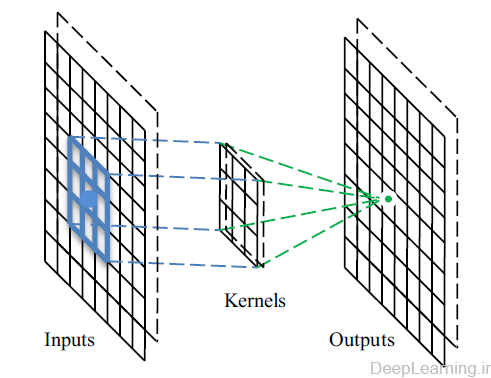

لایه کانولوشن :

در این لایه ها , شبکه CNN از kernel های مختلف برای convolve کردن تصویر ورودی و همینطور feature map های میانی استفاده میکند و اینگونه feature map های مختلفی همانند آنچه در شکل ۳ مشاهده میکنید ایجاد میکند. انجام عملیات convolution سه فایده دارد (۲۲) :

- مکانیزم اشتراک وزن در هر feature map باعث کاهش شدید تعداد پارامترها میشود

- اتصال محلی, ارتباط بین پیکسل های همسایه را یادمیگیرد

- باعث تغییر ناپذیری و ثبات نسبت به تغییر مکان شئ میشود

بواسطه فواید معرفی شده توسط عملیات convolution , بعضی از مقالات تحقیقاتی مشهور از آن جهت جایگزینی لایه های تماما متصل استفاده کردند تا با این کار سرعت فرآیند یادگیری را افزایش دهند (۲۳, ۲۴). یکی از روشهای جالب مدیریت لایه های کانولوشنی, روش (۱۹) Network in Network (NIN) است که در آن ایده اصلی جایگزینی لایه کانولوشنی با یک شبکه عصبی پرسپترون کوچک است که شامل چندین لایه تماما متصل با توابع فعال سازی غیرخطی است. به این ترتیب فیلترهای خطی با شبکه های عصبی غیرخطی جایگزین میشوند. این روش باعث بدست آوردن نتایج خوبی در دسته بندی تصاویر میشود.

- عملیات لایه کانولوشن

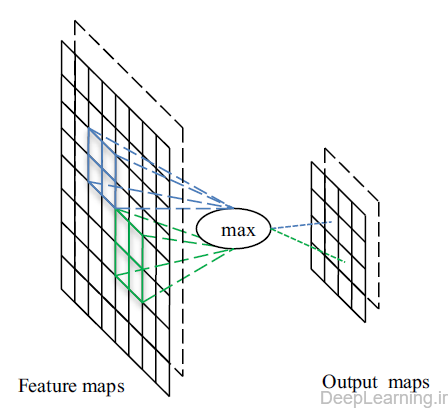

لایه های pooling

یک لایه pooling معمولا بعد از یک لایه کانولوشنی قرار میگیرد و از آن برای کاهش اندازه feature map ها و پارامترهای شبکه میتوان استفاده کرد. همانند لایه های کانولوشنی, لایه های pooling بخاطر در نظر گرفتن پیکسل های همسایه در محاسبات خود, نسبت به تغییر مکان(translation) بی تغییر (با ثبات) هستند. پیاده سازی لایه Pooling با استفاده از تابع max (max pooling) و تابع Average (Average pooling) رایجترین پیاده سازی ها هستند. در شکل ۴ میتوانید نمونه ای از فرایند Max pooling را مشاهده کنید. با استفاده از فیلتر max pooling با اندازه ۲×۲ و stride ۲ یک feature map با اندازه ۸×۸ یک خروجی با اندازه ۴×۴ را ایجاد میکند.

- عملیات max pooling

Boureau et al.(25) تحلیل نظری دقیقی از کارایی max pooling و average pooling ارائه داد. Scherer et al.(26) هم مقایسه ای بین این دو عملیات انجام داد و فهمید max pooling میتواند باعث همگرایی سریعتر , تعمیم بهتر (بهبود تعمیم دهی) و انتخاب ویژگی های نا متغیر بسیار عالی[۹] شود. طی سالهای اخیر پیاده سازی های سریع مختلفی از انواع مختلفی از CNN بر روی GPU انجام شده است که اکثر آنها از عملیات Max pooling استفاده میکنند (۲۱, ۲۷). .

لایه های POOLING از میان سه لایه شبکه های کانولوشن , تنها لایه ای هستند که بیشترین میزان مطالعه روی آنها انجام شده است. سه روش معروف در رابطه با این لایه وجود دارد که هرکدام اهداف متفاوتی را دنبال میکنند.

Stochastic pooling

یک کاستی max pooling این است که نسبت به overfitting مجموعه آموزشی [۱۰] حساس بوده, و تعمیم را سخت میکند. (۲۲) با هدف حل این مشکل, Zeiler et al.(28) روش stochastic pooling را پیشنهاد داد که در آن عملیات قطعی pooling با یک رویه اتفاقی[۱۱] جایگزین میشود. این رویه اتفاقی ,انتخاب تصادفی مقادیر در داخل هر ناحیه Pooling بر اساس یک توزیع چندجمله ای است. این عملیات شبیه max pooling استاندارد با تعداد زیادی کپی از تصویر ورودی که هر کدام تغییرشکل[۱۲] محلی کوچکی دارند است. طبیعت تصادفی (stochastic) بودن برای جلوگیری از مشکل Overfitting مفید بوده و به همین دلیل از آن در این روش استفاده شده است.[۱۳]

Spatial pyramid pooling (SPP)

معمولا روش های مبتنی بر شبکه های عصبی کانولوشن نیازمند یک تصویر ورودی با اندازه ثابت هستند. این محدودیت ممکن است باعث کاهش دقت تشخیص برای تصاویری با اندازه دلخواه شود. به منظور حذف این محدودیت , He et al(29) از یک معماری شبکه عصبی کانولوشن معمولی استفاده کرد با این تفاوت که لایه pooling آخر را با یک لایه spatial pyramid pooling جایگزین نمود. این لایه قادر به استخراج نماد ها (تصاویر) با اندازه ثابت از تصاویر (یا نواحی) دلخواه است. این روش باعث ایجاد یک راه حل قابل انعطاف برای مدیریت مقیاس ها, اندازه ها و aspect ratio های مختلف میشود که میتوان از آن در هر ساختار و معماری CNNی استفاده کرده و کارایی آنرا افزایش داد.

Def-pooling

مدیریت و رسیدگی به تغییر شکل[۱۴] یک چالش اساسی در بینایی کامپیوتر است. خصوصا در زمینه های مربوط به تشخیص اشیاء (object recognition) . Max pooling و Average pooling برای مدیریت تغییر شکل (deformation) مفید اند اما قادر به یادگیری محدودیت تغییر شکل (deformation) و مدل هندسی اجزای شئ نیستند. به منظور مقابله بهتر با تغییر شکل (deformation) , Ouyang et al. (30) یک لایه pooling جدید با تغییر شکل محدود (deformation constrained pooling layer) معرفی کرد. که به def-pooling layer معروف است. تا به این وسیله مدل عمیق (deep model) بدست امده با یادگیری تغیرشکل الگوهای دیداری (deformation of visual patterns.) غنی شود. از این لایه میتوان بجای لایه max pooling در هر سطحی از انتزاع استفاده کرد.

میتوان از ترکیب چندین نوع مختلف لایه pooling که هر کدام با هدف و شیوه متفاوتی توسعه پیدا کرده اند, کارایی یک شبکه عصبی کانولوشن را افزایش داد.

لایه تماما متصل

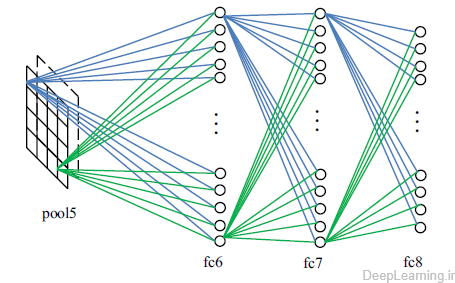

بعد از آخرین لایه Pooling , همانطور که در شکل ۲ مشاهده میشود, لایه های تماما متصل وجود دارند که feature map های ۲ بعدی را به feature vector یک بعدی جهت ادامه فرآیند feature representation تبدیل میکند.

- عملیات لایه های تماما متصل که بعد از آخرین لایه Pooling قرار گرفته اند

لایه های تماما متصل همانند همتایان خود در شبکه های عصبی مصنوعی سنتی عمل میکنند و تقریبا ۹۰% پارامترهای یک شبکه CNN را شامل میشوند. لایه تماما متصل بما اجازه میدهد تا نتیجه شبکه را در قالب یک بردار با اندازه مشخص ارائه کنیم . ما میتوانیم از این بردار برای دسته بندی تصاویر(۲۱) استفاده کنیم و یا اینکه از آن جهت ادامه پردازش های بعدی بهره ببریم .(۳۱)

تغییر ساختار لایه های تماما متصل رایج نیست , اما یک نمونه در روش Transferred learning(32) انجام شد که در آن پارامترهای فراگرفته شده توسط ImageNet(21) حفظ شده اما لایه تماما متصل آخر با دو لایه تماما متصل جایگزین شد تا شبکه با اینکار بتواند با فعالیتهای تشخیص بینایی جدید انطباق پیدا کند.

مشکل بزرگ این نوع لایه ها این است که دارای تعداد بسیار زیادی پارامتر اند. که نتیجه این امر هزینه پردازشی بسیار بالایی است که در زمان آموزش بایستی صرف شود. بنابر این یک روش که معمولا بکاربرده میشود و نتایج رضایت بخشی نیز دارد این است که یا کلا این لایه ها حذف شوند و یا تعداد اتصالات در این لایه ها توسط روشهایی کاهش یابد. بعنوان مثال GoogLeNet(23) یک شبکه عمیق و گسترده را طراحی کرد که در آن هزینه محاسباتی ثابت نگه داشته شده است . این کار با تعویض معماری تماما متصل با معماری بطور پراکنده متصل صورت گرفت.

استراتژی آموزش (Training strategy)

در قیاس با shallow learning , فایده یادگیری عمیق این است که میتوان معماری های عمیق (deep architecture) را جهت یادگیری اطلاعات انتزاعی تر ایجاد کرد . اما تعداد بسیار زیاد پارامترهای معرفی شده, ممکن است سبب مشکل overfitting شود. اخیرا روش های regularization زیادی در مقابله با Overfitting ارائه شده است مثل روش stochastic pooling که در قبل به آن اشاره کردیم . در این بخش ما چند تکنیک و روش regularization را که سبب بهبود کارایی شبکه میشود را معرفی میکنیم .دقت کنید که الزاما تمامی تکنیک های معرفی شده در این بخش ,خاص شبکه های عصبی کانولوشن نیستد. یعنی این تکنیک ها قابل اعمال در شبکه های عصبی مصنوعی سنتی هم هستند (مثل شیوه dropout )

Droppout و DropConnect

تکنیک Dropout توسط Hinton et al.(33) ارائه شد و توسط Baldi et al. (34) هم بصورت کامل توضیح داده شد. روش dropout به منظور جلوگیری از overfitting معرفی شد. و نحوه کار آن به این صورت است که در هر مرحله از آموزش, هر نورون یا با احتمال ۱-p (از شبکه) بیرون انداخته شده (dropped out) و یا با احتمال p نگه داشته میشود, بطوریکه نهایتا یک شبکه کاهش داده شده باقی بماند. یالهای ورودی و خروجی به یک نود بیرون انداخته شده (dropped-out node) نیز حذف میشوند.اینگونه تنها شبکه کاهش یافته بر روی داده ها در آن مرحله آموزش خواهد دید.(بعد از این کار) نودهای حذف شده سپس به همراه وزنهای سابق آنها(قبل از حذف شدن) دوباره به درون شبکه وارد میشوند. این تکنیک بعدا در (۳۵-۴۰) بهبود پیدا کرد. Warde-Farley et al.(38) در تحقیقات خود بهینگی dropout ها را مورد تحلیل قرار داد و نهایتا عنوان کرد که dropout یک شیوه یادگیری گروهی بسیار موثر است.

یک نمونه معروف مشتق شده از Dropout به(۴۱) DropConnect معروف است که بصورت تصادفی وزنها را بجای مقادیر فعالسازی حذف میکند. آزمایشات نشان دادند که این روش میتواند پایاپای و حتی بهتر از روش Dropout در انواع گوناگونی از Benchmark های استاندارد عمل کند. هرچند با سرعت کمتر. شکل ۶ مقایسه ای از یک معماری بدون حذف (No Drop) , Dropout و DropConnect را نشان میدهد. (۴۱)

- مقایسه ای بین شبکه های No-Drop , Dropout و DropConnect.

Data augmentation

معمولا زمانی که از یک CNN برای تشخیص شئ (object recognition) استفاده میشود, از data augmentation برای تولید داده های اضافی بدون تحمیل هزینه برچسب گذاری بیشتر استفاده میکنند. شبکه AlexNet(21) از دو شکل مشخص data augmentation استفاده کرد . اولین شکل data augmentation شامل ایجاد image translation و انعکاس های افقی (horizontal reflections) بود, و دومین شکل شامل تغییر شدت نور در کانالهای RGB تصاویر بود. Howard et al.(42) با انتخاب AlexNet(21) به عنوان مدل پایه خود و بعد با اضافه کردن تبدیلات (transformations) اضافی که توسعه image crops با پیکسلهای اضافی و افزودن تغییرات رنگی بیشتر (color manipulations) بود, باعث بهبود translation invariance و Color Invariance شد. این شیوه data augmentation بصورت گسترده توسط تعدادی از تحقیقات اخیر مورد استفاده قرار گرفته است.. (۲۳, ۲۹) Dosovitskiy et al.(43) یک شیوه یادگیری ویژگی بدون سرپرست (unsupervised feature learning) مبتنی بر data augmentation ارائه داد که در آن شیوه کار به اینصورت است. این روش ابتدا بصورت تصادفی تعدادی image patch را انتخاب کرده و آنها را بعنوان یک کلاس جانشین در نظر میگیرد, سپس این کلاسها را با اعمال تبدیلات مربوط به translation , scale , رنگ و contrast گسترش(بسط) داده و نهایتا یک شبکه CNN را جهت تشخیص و تمایز بین این کلاسهای جانشین(surrogate classes) آموزش میدهد. ویژگی های فراگرفته شده توسط این شبکه نتایج خوبی را در زمینه های مختلف دسته بندی نشان میدهد. Wu et al.(44) علاوه بر روش های کلاسیک همانند scaling, rotating و cropping از color casting, تکنیک های lens distortion و vignetting نیز بهره برد که همین امر باعث ایجاد نمونه های آموزشی بیشتر با پوشش گسترده تری شد.

پیش آموزش و تنظیم دقیق (pre-training and fine-tuning)

پیش آموزش (pre-training)به معنای آماده سازی (مقدار اولیه دادن) شبکه با پارامترهای از قبل آموزش داده شده بجای پارامترهای تصادفی است. این روش در مدلهای مبتنی بر CNN بسیار محبوب است چرا که فرآیند یادگیری را تسریع کرده و همینطور قابلیت تعمیم را بهبود میبخشد. Erhan et al.(45) شبیه سازی های گسترده ای را بر روی الگوریتم های فعلی انجام داد تا دلیل اینکه شبکه های از قبل آموزش داده شده از شبکه هایی که بصورت سنتی آموزش داده میشوند بهتر کار میکنند را بفهمد. از زمانی که AlexNet (۲۱) توانست به کارایی فوق العاده ای دست پیدا کند و بعد از انتشار آن بصورت عمومی , روش های بسیار زیادی AlexNet را که بر روی مجموعه تصاویر ImageNet2012 آموزش دیده بود, بعنوان مدل عمیق پایه (baseline deep model) خود انتخاب کردند. (۳۱, ۳۲, ۴۶) و بعد با روش های اختصاصی خود شروع به تنظیم دقیق (بهینه سازی) (fine-tuning) پارامترهای آن کردند. البته روش های دیگری(۳۰, ۴۷, ۴۸) نیز هستند که با آموزش بر روی مدلهایی مثل Clarifai(49), GoogLeNet (23), و VGG(50) کارایی بهتری ارائه میکنند. تنظیم دقیق (بهینه سازی) (fine-tuning) مرحله ای بسیار حیاتی برای تصحیح کردن مدلهاست تا با مجموعه داده ها و کارهای(فعالیتهای) خاص وقف پیدا کنند. بطور کلی تنظیم دقیق (بهینه سازی) (fine-tuning) نیازمند برچسب برای دسته های مختلف در مجموعه داده آموزشی جدید است که برای محاسبه تابع خطا مورد استفاده قرار میگیرد.

در این حالت, تمامی لایه های مدل جدید بجز لایه خروجی آخر که به تعداد برچسب دسته های مجموعه داده جدید بستگی دارد و بصورت تصادفی مقدار میگیرد, بر اساس مدل از قبل آموزش داده شده مثل AlexNet(21) مقدار دهی میشوند. البته در بعضی موارد, بدست آوردن برچسب دسته ها برای مجموعه داده جدید کار سختی است. برای حل این مشکل, یک تابع هدف یادگیری شباهت (similarity learning objective function) ارائه شد تا بعنوان تابع خطا (loss function) بدون برچسب کلاسها مورد استفاده قرار بگیرد. (۵۱). بنابر این اینطور, عمل backpropagation بصورت معمولی کار کرده و مدل هم میتواند لایه به لایه تصحیح شود. (بهتر شود)

نتایج تحقیقات زیادی وجود دارند که چگونگی انتقال بهینه یک مدل از پیش آموزش داده شده را توضیح میدهند. یک راه جدیددر (۵۲) ارائه شده است که میزان عمومی و یا خاص بودن یک لایه را میتوان بصورت عددی مشخص کرد یعنی اینکه ویژگی های در آن لایه تا چه اندازه از یک کاربرد به کاربرد دیگر بخوبی منتقل شوند. محققان در این تحقیق نتیجه گرفتند که مقدار دهی اولیه یک شبکه با ویژگی های منتقل شده تقریبا از هر تعدادی از لایه ها میتواند باعث بهبود کارایی regularization بعد از بهینه سازی در یک مجموعه داده جدید شود.

علاوه بر روش های regularization که قبلا توضیح داده شدند, روش های رایج دیگری مثل weight decay , weight tying و …. هم وجود دارند. (۱۱). . روش weight decaying با اضافه کردن یک عبارت به تابع هزینه به منظور مجازات پارامترها, باعث جلوگیری آنها از دقیقا مدل کردن داده های آموزشی میشود و اینطور باعث تعمیم مثالهای جدید میشود. (۲۱) .

Weight tying به مدلها اجازه میدهد تا با کاهش تعداد پارامترها در شبکه های عصبی کانولوشن, نمایش های خوبی از داده ورودی را یاد بگیرند(۵۳) . نکته جالب دیگر که باید به آن توجه کرد این است که میتوان برای افزایش کارایی این روشهای regularization را با هم ترکیب کرد و اینطور نیست که تنها قادر به استفاده از یکی از این روشها در معماری خود باشیم .

معماری شبکه های عصبی کانولوشن

با پیشرفت های اخیر استفاده CNN در حوزه بینایی کامپیوتر , مدلهای معروفی از شبکه های عصبی کانولوشن بوجود آمدند. در این بخش ما مدلهایی که بیشتر متداول بوده را مورد مطالعه قرار میدهیم و سپس خصوصیات هریک را در کاربردهای آنها بصورت خلاصه عنوان میکنیم .

پیکربندی و دستاوردهای چند مدل CNN معمولی در جدول ۱ آورده شده است.

AlexNet یک معماری قابل توجه برای شبکه عصبی کانولوشن است که شامل ۵ لایه کانولوشنی و سه لایه تماما متصل است. این معماری تصاویر با اندازه ۲۲۴x224x3 را بعنوان ورودی دریافت کرده و سپس با انجام عملیات های convolution و pooling پی در پی و نهایتا ارسال نتایج به لایه های تماما متصل تصویر ورودی را مورد پردازش قرار میدهد. این شبکه بر روی مجموعه داده ImageNet آموزش دیده و در آن از تکنیک های مختلف regularization همانند data augmentation , Dropout و…. استفاده شده است . این معماری برنده رقابت ILSVRC2012(16) شد و باعث افزایش ناگهانی علاقه به مبحث شبکه های عصبی کانولوشنی عمیق شد.

اما این معماری ۲ مشکل بزرگ دارد که عبارتند از :

- این معماری نیازمند تصاویری با اندازه ثابت است

- هیچ درک درستی از اینکه چرا این معماری به این خوبی کار میکند وجود ندارد.

در سال ۲۰۱۳ , Zeiler et al.(54) روش نمایش بصری نوینی را معرفی کرد که با استفاده از آن میشد فعالیت های صورت گرفته درون لایه های یک شبکه عصبی کانولوشن را مشاهده کرد.

| روش | سال | مقام | پیکربندی | دستاورد |

| AlexNet | ۲۰۱۲ | اول | ۵ لایه کانولوشن + ۳ لایه تماما متصل | معماری مهمی که باعث علاقه بسیاری از محققان در زمینه بینایی کامپیوتر شد |

| Clarifai | ۲۰۱۳ | اول | ۵ لایه کانولوشن + ۳ لایه تماما متصل | باعث شد تا اتفاقاتی که در داخل شبکه رخ میدهد قابل دیدن باشند |

| SPP | ۲۰۱۴ | سوم | ۵ لایه کانولوشن + ۳ لایه تماما متصل | با ارائه spatial pyramid pooling محدودیت اندازه تصاویر را از میان برداشت |

| VGG | ۲۰۱۴ | دوم | ۱۵-۱۳ لایه کانولوشن + ۳ لایه تماما متصل | ارزیابی کاملی از شبکه با عمق افزایشی |

| GoogLeNet | ۲۰۱۴ | اول | ۲۱ لایه کانولوشن + ۱ لایه تماما متصل | افزایش عمق و عرض شبکه را بدون افزایش نیازمندی های محاسباتی |

| ResNet | ۲۰۱۵ | اول | ۱۵۲ لایه کانولوشن +۱ لایه تماما متصل | افزایش عمق شبکه و ارائه روشی جهت جلوگیری از اشباع شدگی گرادیانت |

- مدلهای مطرح CNN به همراه پیکربندی و دستاوردهای هریک در مسابقات ILSVRC

- مدلهای پایه CNN و مدلهای مشتق شده از آنها

این نمایش های بصری به آنها اجازه داد تا معماری هایی که عملکرد به مراتب بهتری از AlexNet در رقابت دسته بندی ImageNet داشتند را پیدا کرده و اینطور مدل نتیجه شده آنها, Clarifai بالاترین کارایی را در رقابت ILSVR2013 بدست آورد.

برای حل “محدودیت نیاز به یک رزولوشن ثابت برای تصاویر ورودی” هم , He et al.(46) یک استراتژی pooling جدید ارائه کرد (spatial pyramid pooling) تا به این وسیله محدودیت اندازه تصویر را از بین بردارد. معماری SPP-net بدست آمده از این روش, علیرغم متفاوت بودن طراحی ها, قادر به بهبود دقت در تعداد متنوعی از معماری های CNN منتشر شده است .

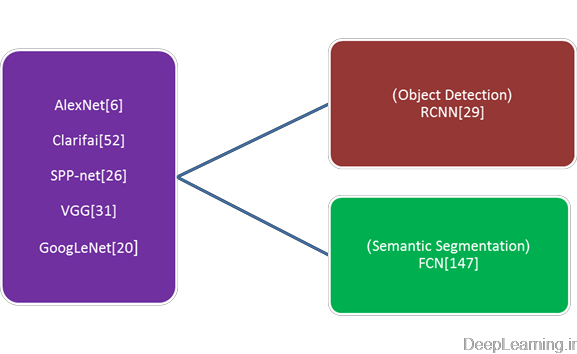

علاوه بر پیکربندی رایج شبکه های عصبی کانولوشن (۵ لایه کانولوشنی به اضافه ۳ لایه تماما متصل) روش های دیگری هم وجود دارند که سعی میکنند شبکه های عمیقتری را مورد کاوش و بررسی قرار دهند.برخلاف AlexNet , VGGNet(50) عمق شبکه را با اضافه کردن تعداد بیشتری از لایه های کانولوشن و استفاده از فیلترهای کانولوشنی کوچک در تمام لایه ها افزایش داد.به همین صورت, Szegedy et al. (23)مدلی بنام GoogLeNet را ارائه داد که ساختار بسیار عمیقی داشت (دارای ۲۲ لایه بود) و توانست در رقابت ILSVRC2014(16) مقام اول را کسب کند. علیرغم کارایی دسته بندی بسیار بالا که توسط مدلهای مختلف بدست آمد, مدلهای مبتنی بر CNN و کاربردهای مختلف آنها تنها محدود به دسته بندی تصاویر نیستند. بر اساس این مدلها, چارچوبهای جدیدی بدست آمد تا برای استفاده در کارهای سخت دیگری همانند شناسایی شیئ (object detection) , Semantic segmentation و… قابل استفاده باشند.

دو چارچوب مشتق شده معروف در این زمینه وجود دارد : RCNN(Regions with CNN features) (31) و FCN(Fully convolutional network(48) ) که به ترتیب در اصل برای object detection و semantic segmentation طراحی شده اند. ایده اصلی RCNN ایجاد پیشنهادهای چندگانه (multiple object proposals) , استخراج ویژگی ها از هریک با استفاده از یک CNN و سپس دسته بندی هر پنجره کاندید, با یک SVM خطی مختص هر دسته, است. طرح “تشخیص از طریق ناحیه ها” (recognition using regions) کارایی دلگرم کننده ای در Object detection بدست آورد و کم کم به معماری کلی برای الگوریتم های نوید بخش اخیر در شناسایی اشیاء (object detection) تبدیل شده است. (۵۵-۵۸)

البته کارایی RCNN بیش از حد روی دقت مکان شئ تکیه دارد که همین امر ممکن است قدرت آنرا محدود کند. علاوه بر این, ایجاد و پردازش تعداد زیادی از پیشنهادها ممکن است بهینگی آنرا کاهش دهد. پیشرفت های اخیر در این حوزه (۵۵, ۵۶, ۵۸-۶۰) عمدتا بر روی این دو مبحث تمرکز کرده اند.

RCNN مدلهای CNN را بعنوان یک استخراجگر ویژگی (feature extractor) مورد استفاده قرار داده و هیچ تغییری در شبکه اعمال نمیکند. اما برخلاف آن, FCN روشی برای از نو طرح کردن مدلهای CNN بصورت شبکه های تمام کانولوشنی ارائه میکند و قادر به تولید خروجی هایی با اندازه متناسب بصورت بهینه است.گرچه FCN عمدتا برای semantic segmentation ارائه شده است اما این تکنیک را میتوان در کاربردهای دیگر نظیر دسته بندی تصاویر (۶۱) , لبه یابی(۶۲) وغیره نیز مورد استفاده قرار داد.

گذشته از ایجاد مدلهای متنوع, کاربرد این مدلها یکسری خصوصیتها را نشان میدهد:

شبکه های عظیم

یک ایده شهودی این است که کارایی شبکه های کانولوشن را با افزایش اندازه آنها که شامل افزایش عمق (تعداد سطوح) و عرض آن (تعداد واحدها در هر سطح) (۲۳) افزایش دهیم. هم GoogLeNet(23) و هم VGGNet(50) که پیشتر توضیح داده شده اند, از شبکه های بسیار بزرگ , به ترتیب با ۲۲ و ۱۹ لایه استفاده کردند و با این کار نشان دادند که افزایش اندازه برای دقت تشخیص تصویر سودمند است.

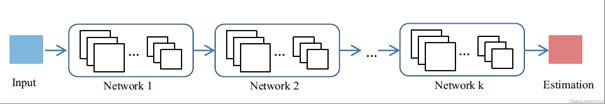

آموزش چندین شبکه بطور مشترک میتواند سبب کارایی بهتر نسبت به آموزش یک شبکه به تنهایی شود. محققان بسیاری وجود دارند (۳۰, ۶۳, ۶۴) که شبکه های بزرگی را با ترکیب ساختارهای عمیق مختلف بصورت آبشاری طراحی کرده اند که در آن خروجی یک شبکه توسط شبکه دیگر مورد استفاده قرار میگیرد . این مسئله در شکل ۸ نمایش داده شده است. ساختار آبشاری را میتوان برای استفاده در کارهای مختلف مورد استفاده قرار داد و عملکرد شبکه های ابتدایی (یعنی خروجی آنها) ممکن است با توجه به کاربرد موردنظر تغییر کند. بعنوان مثال Wang et al.(64) دو شبکه را برای object extraction بهم متصل کرده و اولین شبکه برای object localization مورد استفاده قرار گرفت که خروجی آن مختصات متناظر با شئ بود. Sun et al.(63) شبکه های کانولوشنی سه سطحی با دقت طراحی شده را برای شناسایی نقاط کلیدی صورت (facial keypoints) ارائه داد که در آن سطح اول تخمین های اولیه بسیار قدرتمندی را فراهم میکرد در حالی که دو سطح بعدی اقدام به تنظیم دقیق (بهینه سازی =fine-tuning ) این تخمین اولیه میکردند. به همین شکل, Ouyang et al. (30) یک طرح آموزش چند مرحله ای که توسط Zeng et al.(65) ارائه شده بود را مورد استفاده قرار داد. به این معنی که دسته بندی کننده هایی در مراحل قبلی بصورت مشترک با دسته بندی کننده هایی در مرحله فعلی کار کرده تا به نمونه هایی که اشتباها دسته بندی شده اند رسیدگی کنند.

- ترکیب ساختارهای عمیق بصورت آبشاری

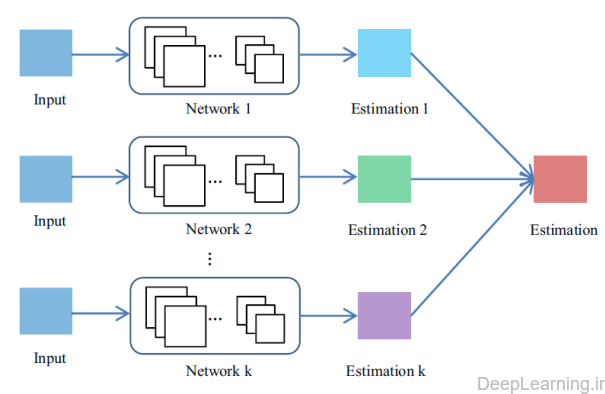

چندین شبکه :

یک گرایش دیگر در کاربردهای فعلی این است که بجای طراحی یک معماری منفرد (single architecture)و آموزش مشترک تمام شبکه های داخلی آن به منظور اجرای یک کار(فعالیت) , نتایج چندین شبکه را که هر کدام قادر به اجرای مستقل کاری هستند, ترکیب کنند. این مسئله در شکل ۹ نمایش داده شده است.

- ترکیب نتایج حاصل از چند شبکه

Miclut et al. (66) نشان داد که چگونه باید نتایج نهایی را در زمان دریافت مجموعه امتیازات ایجاد کرد. قبل از AlexNet(21) , Ciresan et al. [5] روشی بنام Multi-Column DNN (MCDNN) ارائه کرد که در آن چندین ستون DNN با هم ترکیب شده و تخمین های آنها میانگین گرفته میشد. این مدل توانست به نتایج قابل رقابت با انسان در کارهایی مثل تشخیص ارقام با دست نوشته شده یا علامتهای راهنمایی رانندگی (traffic signs) دست پیدا کند. اخیرا Ouyang et al. (30) آزمایشی را جهت ارزیابی کارایی استراتژی های ترکیب مدلها باهم, انجام داد. طی این آزمایش او ۱۰ مدل را با تنظیمات مختلف آموزش داده و سپس آنها را در یک طرح میانگین گیری (averaging scheme) با هم ترکیب کرد. نتایج حاصله نشان دادند که مدلهای تولید شده به این شکل, تنوع بالایی داشته و بصورت مکمل نسبت به همدیگر عمل میکنند که همین امر باعث بهبود نتایج تشخیص (detection results) میشود.

شبکه های متنوع (Diverse networks)

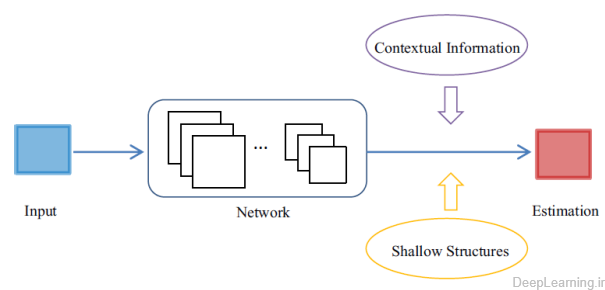

گذشته از تغییر ساختار CNN , بعضی از محققان تلاش کردند تا اطلاعات را از منابع دیگری مثل ترکیب آنها با ساختار های کم عمق (shallow structures) و ادغام اطلاعات متنی(زمینه ای) (integrating contextual information) , بدست آورده و به مدل ارائه کنند.

- ترکیب یک شبکه عمیق با منابع اطلاعاتی دیگر

روش های کم عمق (shallow methods) میتوانند دیدی اضافی از مشکل ارائه دهند. در ادبیات (تحقیقات) (literature) میتوان نمونه هایی در باره ترکیب روش های کم عمق با چارچوب های یادگیری عمیق یافت (۶۷). این به عبارت دیگر یعنی یک روش یادگیری عمیق را گرفته و از آن برای استخراج ویژگی ها مورد استفاده قرار دهیم . سپس این ویژگی ها را به یک روش shallow learning مثل یک SVM ارائه کنیم . یکی از بهترین و موفقترین الگوریتم ها در این زمینه روش RCNN(31) است که ویژگی های CNN بسیار متمایز را به یک SVM ارائه کرده تا کار تشخیص شئ (object detection)نهایی انجام شود. علاوه بر این, شبکه های عصبی کانولوشن عمیق و بردار های فیشر (Fisher Vectors) مکمل یکدیگر بوده و میتوانند در صورت ترکیب شدن با هم بصورت قابل ملاحظه ای دقت دسته بندی تصاویر را بهبود دهند. (۶۸)

گاهی اوقات اطلاعات متنی (زمینه ای) (contextual information) برای یک فعالیت مثل تشخیص شئ (object detection) موجود بوده و امکان ادغام اطلاعات متنی سراسری با اطلاعات جعبه شناسایی (bounding box) وجود دارد. در رقابت تشخیص بینایی مقیاس بزرگ ImageNet در سال ۲۰۱۴ (به اختصار ILSVRC2014) تیم برنده, تمامی امتیازات خام مربوط به تشخیص (raw detection scores) را بهم متصل کرده و آنها را با خروجی های حاصله از یک چارچوب دسته بندی سنتی(traditional classification framework) با استفاده از context refinement(69) ترکیب کرد. بطور مشابه, Ouyang et al. (30), نیز امتیازات دسته بندی تصاویر (۱۰۰۰ دسته ای) را بعنوان ویژگی های متنی برای object detection مورد استفاده قرار داد.

۱-۲-۲-Restricted Boltzmann Machines (RBMs)

یک ماشین بولتزمن محدود شده (Restricted Boltzmann Machines (RBMs)) یک شبکه عصبی مولد تصادفی (generative stochastic neural network) است که توسط Hinton et al. در سال ۱۹۸۶ ارائه شد .(۷۰) یک RBM گونه ای از یک ماشین بولتزمن (Boltzman Machine) است که دارای محدودیتی است که در آن واحدهای مشخص (visible units) و واحدهای پنهان(hidden units) باید تشکیل یک گراف دو قسمتی(bipartite graph) را دهند . این محدودیت باعث ایجاد الگوریتم های آموزشی بهینه تر ,علی الخصوص الگوریتم واگرایی تقابلی مبتنی بر گرادیانت (gradient-based contrastive divergence) میشود. (۷۱).از آنجایی که این مدل یک گراف دو قسمتی (bipartite graph) است, واحدهای پنهان (hidden units) H و واحدهای مشخص (visible units) V1 بصورت مشروط مستقل اند. بنابر این در معادله زیر

هم H و هم V1 توزیع بولتزمن را برآورده(satisfy) میکنند. با ورودی V1 ما میتوانیم H را از طریق ![]() بدست بیاوریم. به همین شکل ما میتوانیم مقدار V2 را از طریق

بدست بیاوریم. به همین شکل ما میتوانیم مقدار V2 را از طریق ![]() بدست بیاوریم . با تنظیم پارامترها, ما میتوانیم اختلاف بین V1 و V2را به حداقل برسانیم و H نتیجه شده بعنوان یک ویژگی خوب از V1 عمل خواهد کرد.

بدست بیاوریم . با تنظیم پارامترها, ما میتوانیم اختلاف بین V1 و V2را به حداقل برسانیم و H نتیجه شده بعنوان یک ویژگی خوب از V1 عمل خواهد کرد.

Hinton(72) توضیح مبسوطی در این زمینه داد و یک راه عملی برای آموزش RBMها فراهم کرد. در (۷۳)مشکلات اصلی آموزش RBM ها و دلایل زیربنایی آنها مورد بحث قرار گرفته و یک الگوریتم جدید که شامل نرخ یادگیری قابل تطبیق (Adaptive learning rate) و گرادیانت بهبود یافته برای رفع مشکلات مطرحی بود, ارائه شد. یک نمونه مشهور از RBM را میتوان در (۷۴)یافت. این مدل واحدهای دودویی (binary unites) را به همراه واحدهای خطی تصحیح شده نویزدار (noisy rectified linear units) به منظور حفظ اطلاعات در مورد شدتهای نسبی(relative intensities) در حین گردش اطلاعات در لایه ها تقریب میزند. نه تنها این اصلاح (refinement) در این مدل بخوبی کار میکند بلکه بصورت گسترده در روشهای مختلف مبتنی بر CNN نیز بکار برده میشود(۲۱, ۲۸).

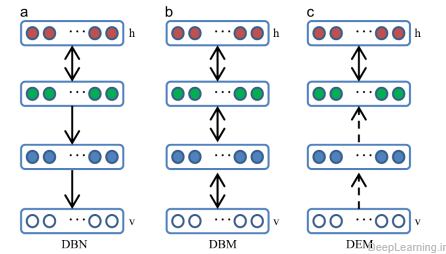

با استفاده از RBM ها بعنوان ماجول های یادگیری, ما میتوانیم مدلهای عمیق Deep Belief Networks(DBNs) , Deep Boltzman Machines(DBMs) و Deep Energy Models(DEMs) را ایجاد کنیم .مقایسه میان این سه مدل در شکل ۱۱ نشان داده شده است . DBN ها دارای اتصالات بیجهت (undirected connections) در دو لایه بالایی که تشکیل یک RBM را داده و دارای اتصالات هدایت شده(جهت دار) در لایه های پایینی هستند .DBM ها دارای اتصالات بیجهت بین تمامی لایه های شبکه هستند. DEM ها هم دارای واحدهای پنهان قطعی (deterministic hidden units) برای لایه های پایین و واحدهای پنهان تصادفی (stochastic hidden units) برای لایه بالا (top hidden layer) هستند. (۷۵).

- مقایسه سه مدل عمیق DBNوDBM و DEM

خلاصه ای از این سه مدل به همراه نمونه کارهای انجام شده با آنها را در جدول ۲ مشاهده میکنید .

خلاصه ای از روشهای مبتنی بر RBM .

| مراجع | نکات منفی(کاستی ها) | نکات مثبت | مشخصه ها | روش |

| Yanming Guo et all(review) | بخاطر فرآیند مقداردهی اولیه, ایجاد یک مدل DBN از لحاظ محاسباتی هزینه بر است | ۱٫شبکه را بطور مناسب مقداردهی اولیه میکند و تا حدودی از افتادن در بهینه محلی ضعیف جلوگیری میکند

۲٫ فرآیند آموزش بدون سرپرست است که به همین علت ضرورت وجود داده برچسب گذاری شده برای آموزش را از بین میبرد.

|

اتصالات بدون جهت در دو لایه بالایی و اتصالات جهت دار در لایه های پایینی | DBN |

| Yanming Guo et all(review) | بهینه سازی مشترک(joint optimization) زمان بر است | با ورودی های مبهم بوسیله استفاده از بازخورد بالا به پایین بهتر برخورد میکند | اتصالات بی جهت بین تمامی لایه ها در شبکه

|

DBM |

| Yanming Guo et all(review) | وزن اولیه فراگرفته شده ممکن است همگرایی خوبی نداشته باشد

|

مدلهای مولد بهتری را با اجازه دادن به لایه های پایینی به تطبیق با آموزش لایه های بالایی ایجاد میکند. | واحدهای پنهان قطعی در لایه های زیرین و واحدهای پنهان تصادفی در لایه مخفی بالایی | DEM |

- خلاصه ای از سه مدل و نمونه کارهای انجام شده هریک

شبکه باور عمیق یا همان Deep Belief Network (DBN)توسط Hinton ارائه شد. (۷۶) این شبکه پیشرفت قابل ملاحظه ای در یادگیری عمیق بود. DBN یک مدل مولد احتمالی است که توزیع احتمال مشترک بر روی داده های قابل مشاهده و برچسب ها را فراهم میکند. یک DBN ابتدا از یک استراتژی یادگیری حریصانه لایه به لایه بهینه (efficient layer by layer greedy learning strategy ) برای مقدار دهی اولیه (پارامترهای) شبکه عمیق (deep network) استفاده کرده و سپس تمامی وزنها را بطور مشترک با خروجی های مورد انتظار بدقت تنظیم (fine-tune) میکند.

رویه یادگیری حریصانه دو فایده دارد(۷۷) . ۱) مقدار دهی اولیه مناسبی را برای شبکه ایجاد میکند و با اینکار به سختی ای که در انتخاب پارامتر وجود داشته و ممکن است باعث انتخاب local optima ضعیف شود تا حدی پاسخ میدهد ۲)رویه یادگیری بدون سرپرست (unsupervised ) بوده و به هیچ برچسب دسته ای (class label) نیاز ندارد بنابر این ضرورت داده برچسب دار برای آموزش را از میان برمیدارد. ایجاد یک مدل DBN اما از لحاظ محاسباتی کار بسیار پرهزینه ای است چراکه نیازمند آموزش چندیدن RBM بوده و مشخص هم نیست که چگونه میتوان حداکثر احتمال آموزش برای بهینه سازی مدل را تقریب زد. (۷۶).

DBN ها با موفقیت توجه محققان را به یادگیری عمیق معطوف کردند و در نتیجه, گونه های زیادی از آنها تولید شدند (۷۸-۸۱)

Nair et al.(81) یک DBN تغییر یافته را توسعه داد که در آن مدل لایه بالایی از یک ماشین بوتلزمن درجه ۳ (third order Boltzman Machine) برای تشخیص اشیاء (object recognition) استفاده میکرد .مدل ارائه شده در (۷۸)یک مدل دو لایه از تصاویر طبیعی را با استفاده از sparse RBM ها که در آن لایه اول فیلترهای محلی, جهت دار و لبه ای را یاد گرفته و لایه دوم تعداد متنوعی از ویژگی های contour را به همراه گوشه ها و تقاطعها دریافت میکرد. فرا گرفت. به منظور بهبود قدرت مدل در برابر انسداد (occlusion) و نویزهای تصادفی(random noie) , Lee et al.(82) از ۲ استراتژی استفاده کرد.استراتژی اول بهره بردن از اتصالات تنک (sparse connection) در لایه اول DBN به منظور regularize کردن مدل بود و استراتژی دوم توسعه یک الگوریتم حذف نویز احتمالاتی (probabilistic de-noising algorithm) بود. درصورتی که قصد این را داشته باشیم تا از این شبکه در فعالیت های بینایی کامپیوتر استفاده کنیم ,به مشکل برخواهیم خورد. مشکل DBN این است که آنها ساختار ۲بعدی یک تصویر ورودی را در نظر نمیگیرند. برای رفع این مشکل, شبکه باور عمیق کانولوشنی (Convolutional Deep Belief Network) یا به اختصار CDBN ها معرفی شدند(۷۹). CDBN از اطلاعات مکانی پیکسهای همسایه با معرفی RBM کانولوشنی, بهره میبرد و با این کار یک مدل مولد translation invariant که بخوبی با تصاویر با اندازه های بزرگ مقیاس پذیر است ایجاد میکند. این الگوریتم در(۸۳) بیشتر بسط داده شد و کارایی بسیار عالی در تایید صورت(face verification) بدست آورد.

۱-۲-۳-Deep Boltzmann Machines (DBMs)

ماشین بولتزمن عمیق یا به اختصار DBM , توسط et al.(84) Salakhutdinov ارائه شد و یکی دیگر از الگوریتم های یادگیری عمیق است که در آن, واحدهای پردازشی در لایه هایی قرار میگیرند.در قیاس با DBN ها که دو لایه بالایی تشکیل یک مدل گرافی بی جهت و لایه های پایینی تشکیل یک مدل مولد جهت دار را میداد, DBM دارای اتصالاتی در سراسر ساختار خود است .

همانند RBM , DBM هم یکی از زیرمجموعه های خانواده Boltzmann است. تفاوت انها در این است که DBM ها دارای چندین لایه حاوی واحدهای پنهان (hidden units) بوده که واحدهای موجود در لایه های با شماره فرد بصورت شرطی مستقل از لایه های با شماره زوج هستند و بلعکس.

با وجود واحدهای مشخص (visible units) محاسبه توزیع خلفی ( Posterior) بر روی واحدهای پنهان ,دیگر قابل پیگیری نیست , که این نتیجه تعامل (interactions) بین واحدهای پنهان است. در زمان آموزش شبکه, یک DBM بصورت مشترک تمامی لایه های یک مدل بدون سرپرست خاص (specific unsupervised model) را آموزش داده و بجای بیشینه سازی احتمال بصورت مستقیم, از الگوریتم مبتنی بر احتمال بیشینه تصادفی (stochastic maximum likelihood) یا به اختصار SML برای بیشینه سازی مرزپایینی در احتمال استفاده میکند. (۸۵) به عبارت بهتر این به معنای اعمال تنها یک و یا چند بروز آوری با استفاده از روش Markov chain Monte Carlo (MCMC) بین هر بروز آوری پارامتر است. به منظور جلوگیری از رسیدن به local minima ضعیف که بسیاری از واحدهای پنهان را بطور غیرفعال رها میکند, یک استراتژی آموزش مبتنی بر لایه حریصانه نیز به لایه ها در زمان پیش آموزش شبکه DBM که بسیار شبیه همان چیزی است که در DBN(76) انجام میشود, اضافه میشود.

آموزش مشترک بهبودهای نویدبخشی را هم در احتمال و هم در کارایی دسته بندی feature learner های عمیق به ارمغان اورده است . اما کاستی مهم DBM ها پیچیدگی زمانی استنتاج تقریب است که بسیار بالاتر از DBNهاست. که همین امر بهینه سازی مشترک پارامترهای DBM را برای مجموعه داده های عظیم غیرعملی میکند. به منظور افزایش بهره ور ی (بهینگی) DBM ها , بعضی از محققان الگوریتم استتنتاج تقریبی را معرفی کرده اند (۸۶, ۸۷)که از یک مدل تشخیص (recognition model) برای مقداردهی اولیه مقادیر متغییرهای پنهان(latent variables) در تمام لایه ها استفاده میکند و اینطور بطور موثری باعث تسریع استنتاج (inference) میشود. روشهای زیاد دیگری هم وجود دارند که بدنبال بهبود اثرگذاری DBM ها هستند. بهبودها یا در مرحله پیش آموزش (۸۸, ۸۹)و یا در ابتدای مرحله آموزش (۹۰, ۹۱) میتوانند اتفاق بیفتند. بعنوان مثال Montavon et al. (90) یک لم مرکزی (centering trick) برای بهبود ثبات یک DBM ارائه کرد و آنرا بیشتر افتراقی و مولد(discriminative and generative) کرد. طرح آموزشی پیش بینی چندگانه (۹۲) (Multi-prediction training scheme) به منظور آموزش مشترک DBM مورد بهره برداری قرار گرفت که باعث شد عملکرد به مراتب بهتری از متدهای قبلی در دسته بندی تصاویر مطرح شده در (۹۱)را داشته باشد.

۱-۲-۴-مدل انرژی عمیق (Deep Energy Model (DEM))

DEM توسط Ngiam et al. (75), ارئه شده و روشی نوین برای آموزش معماری های عمیق است. برخلاف DBN ها و DBM ها که در خصوصیت داشتن چندین لایه پنهان تصادفی (multiple stochastic hidden layers) دارای اشتراک هستند, DEM به منظور بهینگی آموزش و استنتاج تنها یک لایه حاوی واحدهای پنهان تصادفی(stochastic hidden units) دارد.

این مدل از شبکه های عصبی feed forward برای مدل کردن از energy landscape بهره برده و قادر است تمامی لایه ها را در آن واحد آموزش دهد. با ارزیابی کارایی این مدل بر روی تصاویر طبیعی, مشخص میشود که آموزش مشترک چندین لایه باعث بهبود کمی و کیفی نسبت به آموزش لایه به لایه حریصانه (greedy layer-wise training) میشود. Ngiam et al. (75) از Hybrid Monte Carlo (HMC) برای آموزش این مدل استفاده کرد. گزینه های دیگری همانند واگرایی تقابلی (contrastive divergence) , score matching و … نیز وجود دارند. کارهای مشابه ای را نیز میتوان در [۷۴](۹۳) یافت.

هرچند RMB ها مثل شبکه های عصبی کانولوشن برای کاربردهای بینایی کامپیوتر مناسب نیستند, اما نمونه های خوبی که از RMB ها جهت استفاده در فعالیتهای مربوط به بینایی کامپیوتر بهره بردند نیز وجود دارد. The Shape Boltzmann Machine توسط Eslami et al.(94) برای استفاده در کارهای مدلینگ binary shape images ارائه شد که توزیع احتمال با کیفیتی (high quality probability distributions) بر روی object shape ها هم به منظور واقعگرایی مثالها از توزیع (realism of samples from the distribution) و هم تعمیم به مثالهای جدید همان shape class را فرا میگرفت. Kae et al. (95) مدل CRF و RBM را با هم ترکیب کرد تا هم ساختار محلی و هم سراسری در قطعه بندی صورت را مدل کند . که این امر باعث کاهش پیوسته خطا در برچسب گذاری صورت(face labeling) شد. یک معماری عمیق جدید که برای تشخیص صدا (phone recognition) ارائه شد (۹۶)ماجول feature extraction یک RBM Mean-Covariance را با DBN استاندارد باهم ترکیب کرد. این روش هم با مشکلات نابهینگی نمایشی (representational inefficiency issues) GMM ها و هم یک محدودیت مهم در کار قبلی که DBN ها در تشخیص صدا بهره برده بود ,مقابله میکند.

۱-۲-۵- Autoencoder

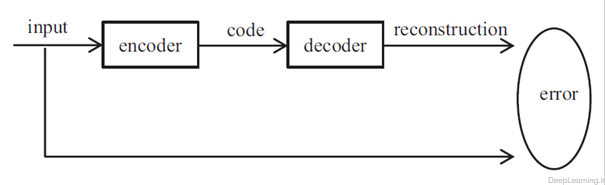

Autoencoder نوع خاصی از شبکه عصبی مصنوعی است که برای encode کردن بهینه یادگیری مورد استفاده قرار میگیرد(۹۷) بجای آموزش شبکه و پیش بینی مقدار هدف Y در ازای ورودی X , یک autoencoder آموزش میبینید تا ورودی X خود را بازسازی کند. بنابر این بردارهای خروجی همان ابعاد بردار ورودی را خواهند داشت. فرآیند کلی یک autoencoder در شکل ۱۲ نشان داده شده است. در حین این فرآیند, autoencoder با کمینه سازی خطای نوسازی (reconstruction error) بهینه میشود. کد متناظر همان ویژگی فراگرفته شده است.

- فرآیند کلی یک autoencoder

بطور کلی, یک لایه ی تنها ,قادر به دریافت ویژگی های متمایز از داده خام نیست . محققان در حال حاضر از autoendocer عمیق استفاده میکنند که کد یادگرفته شده از autoencoder قبلی را به autoencoder بعدی جهت به انجام رساندن کار خود ارسال میکنند.

Autoencoder عمیق (deep autoencoder) توسط Hinton et al.(98) ارائه شد و هنوز بصورت گسترده در مقاله های اخیر مورد مطالعه قرار میگیرد (۹۹-۱۰۱) . یک Autoencoder عمیق اغلب با گونه ای از عملیات back-propagation مثل روش conjugate gradient آموزش میبینید. هرچند اغلب این مدل کارآمد و موثر است , اما درصورت وقوع خطا در لایه های اول میتواند بشدت ناکارآمد شود. این مسئله ممکن است باعث شود تا شبکه میانگین داده های آموزشی را بازسازی کند. یک روش مناسب جهت حذف این مشکل پیش آموزش (pre-training) شبکه با وزن های اولیه که راه حل نهایی را تقریب میزنند است. (۹۸) گونه هایی از autoencoderها هم وجود دارند که پیشنهاد کردند نمایش ها (representation) را تا حد امکان با توجه به تغییرات در ورودی ثابت نگه داشته شوند.

در جدول شماره ۳ , لیستی شامل گونه های معروف autoencoder به همراه خلاصه ای از خصائص و فواید آنها آمده است.

| روش | ویژگی ها | نکات مثبت |

| Sparse Autoencoder | Adds a sparsity penalty to force the representation to be sparse | ۱٫ Make the categories to be more separable

۲٫ Make the complex data more meaningful ۳٫ In line with biological vision system |

| Denoising Autoencoder | Recovers the correct input from a corrupted version | More robust to noise |

| Contractive Autoencoder | Adds an analytic contractive penalty to the reconstruction error

function |

Better captures the local directions of variation dictated by the data |

| Saturating autoencoder | Raises reconstruction error for inputs not near the data manifold | Limits the ability to reconstruct inputs which are not near the data manifold |

| Convolutional autoencoder | Shares weights among all locations in the input, preserving spatial

locality |

Utilizes the 2D image structure |

| Zero-bias autoencoder | Utilizes proper shrinkage function to train autoencoders without

additional regularization |

More powerful in learning representations on data with very high intrinsic dimensionality |

- لیستی شامل گونه های معروف autoencoder به همراه خلاصه ای از خصائص آنها

۱-۲-۶-Sparse autoencoder

Sparse autoencoder ها بدنبال استخراج ویژگی های پراکنده (sparse features) از داده خام هستند. پراکندگی نمودها میتواند یا از طریق جریمه (penalizing) بایاس های واحد پنهان (۷۸, ۱۰۲, ۱۰۳)(hidden unit biases) و یا مستقیما با جریمه (penalizing) خروجی مقادیر واحد پنهان بدست بیایند. (۱۰۲, ۱۰۴) بازنمودهای پراکنده (sparse representations) دارای چندین فایده احتمالی اند (۱۰۳)که عبارتند از : ۱) استفاده از نمودهای با ابعاد زیاد باعث افزایش احتمال انکه دسته های متفاوت براحتی همانند نظریه موجود در SVM , قابل جداشدن از هم باشند میشود. ۲ )نمودهای پراکنده (sparse representations) برای ما تفسیر ساده ای از داده ورودی پیچیده را در قالب تعدادی بخش فراهم میکنند. ۳) دید بیولوژیکی از نمودهای پراکنده در نواحی دیداری ابتدایی استفاده میکند. (۱۰۵)

گونه بسیار مشهوری از sparse autoencoder یک مدل ۹ لایه ای بصورت محلی متصل با pooling و نرمال سازی contrast است .(۱۰۶). این مدل به سیستم اجازه میدهد تا یک صورت یاب را بدون نیاز به برچسب زنی تصاویر بصورت “حاوی صورت و بدون صورت ” آموزش دهد. ویژگی یاب (feature detector) حاصل , برای translation , scaling و چرخش خارج از plane (out-of-plane rotation) بسیار قدرتمند است.

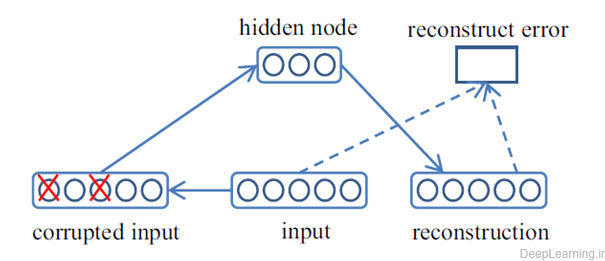

۱-۲-۷-Denoising autoencoder

به منظور افزایش قدرت این مدل, Vincent مدلی بنام denoising autoencoder (DAE) (107, 108) را ارئه داد که قادر به بازیابی ورودی صحیح از نسخه خراب بود. و به این ترتیب مدل را به گرفتن(capture) ساختار توزیع ورودی مجبور میکرد. فرآیند یک DAE در شکل ۱۳ نشان داده شده است .

- Denoising autoencoder

۱-۲-۸-Contractive autoencoder

Contractive autoencoder یا به اختصار CAE , توسط Rifai et al.(109) ارائه شد که دنباله DAE بوده و انگیزه مشابه ای از یادگیری قدرتمند نمودها (representation) با آن داشت . (۷۶). در حالی که DAE با تزریق نویز در مجموعه آموزشی باعث قدرتمند کردن تمامی عملیات mapping میشد, CAE با اضافه کردن جریمه contactive تحلیلی (Analytic contractive penalty) به تابع خطای بازسازی به این مهم دست پیدا میکرد.

هرچند تفاوتهای قابل توجه بین DAE و CAE توسط Bengio et al. (76) عنوان شدند , اما Alain et al.(110) بیان کرد که DAE و یک شکل از CAE بسیار نزدیک به هم هستند. یک DAE با نویز خرابی کوچک (small corruption noise) را میتوان بصورت گونه ای از CAE که در آن جریمه contactive بجای اینکه بروی encoder باشد بر روی کل تابع نوسازی بوده در نظر گرفت. هم DAE و هم CAE هردو بصورت موفقیت آمیزی در رقابت transfer learning و بی سرپرست (unsupervised) مورد استفاده قرار گرفتند.(۱۱۱)

۱-۲-۹-Sparse Coding

Sparse Coding نوعی روش بدون سرپرست است که به منظور یادگیری مجموعه over-complete از توابع پایه (basic functions) برای توصیف داده ورودی مورد استفاده قرار میگیرد.(۱۱۲) . این روش مزیتهای متعددی دارد (۱۱۳-۱۱۶) بعنوان مثال میتوان به این موارد اشاره کرد : ۱) این روش قادر به بازسازی بهتر توصیفگر[۱۵] با استفاده از چندین پایه[۱۶] و گرفتن(دریافت) ارتباطات بین توصیف گرهای مشابه که دارای پایه های مشترک اند, است . ۲)پراکندگی این اجازه را میدهد تا بازنمود [۱۷] , خصائص برجسته تصاویر را دریافت کند ۳)این روش همسو با سیستم بینایی بیولوژیکی است که استدلال میکند ویژگی های پراکنده سیگنالها برای یادگیری مفید هستند. ۴) مطالعه آمار تصاویر نشان میدهد کهimage patch ها سیگنالهای پراکنده هستند. ۵) الگوها با ویژگی های پراکنده از لحاظ خطی بیشتر قابل جداسازی هستند.

الگوریتم های مطرح Sparse coding

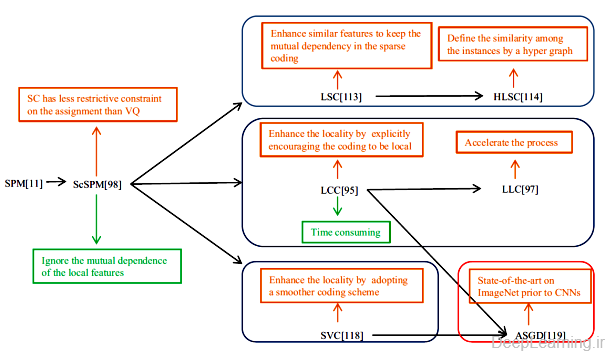

در این بخش ما به توضیح تعدادی از الگوریتم های مطرح Sparse Coding در حوزه بینایی کامپیوتر میپردازیم . در شکل ۱۴ بعضی از این الگوریتم ها به همراه دستاوردها و مشکلات آنها نمایش داده شده اند.

- دستاوردها و مشکلات تعدادی از الگوریتم های مطرح Sparse Coding

یک نمونه از الگوریتم های sparse coding , الگوریتم sparse coding SPM یا به اختصار ScSPM(115) است. که بسطی(extension) از الگوریتم (۱۱۷) Spatial Pyramid Matching (SPM) است برخلاف SPM که از vector quantization (VQ) برای نمایش تصویر استفاده میکند, ScSPM از Sparse coding(SC) به همراه multi scale spatial max pooling برای این منظور استفاده میکند. Codebook مربوط به Sparse coding یک over-complete basis بوده و هر ویژگی (feature) قادر به فعالسازی تعداد کمی از آنها میباشد. در قیاس با VQ , sparse coding خطای بازسازی بسیار کمتری را بواسطه قید نسبتا آزاد تری (less restrictive constraint) که بروی عمل انتساب لحاظ میکند دارد. Coates et al در رابطه با دلایل موفقیت spars coding نسبت به vector quantization تحقیقات بیشتری انجام داد و نتایج را در قالب مقاله ای (۱۱۸) با جزییات فراوان ارائه نمود. یک اشکال ScSPM این است که این روش بصورت جداگانه با ویژگی های محلی برخورد میکند(deals with) و به این ترتیب وابستگی دوطرفه بین آنها را نادیده میگیرد. که این خود باعث حساسیت بیش از حد به feature variance میشود. این یعنی sparse code ها ممکن است حتی برای ویژگی های مشابه هم نیز بشدت تغییر کنند.

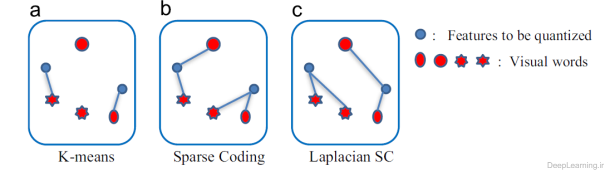

به منظور برطرف سازی این مشکل, , Gao et al.(119) طی مقاله ای , روش Sparse Coding لاپلاسی (Lapacian Sparse Coding) یا به اختصار LSC را ارائه کرد که در آن ویژگی های مشابه نه تنها به مراکز دسته های بطور بهینه انتخاب شده انتساب داده میشوند بلکه تضمین میشود که مراکز دسته های انتخابی مشابه یکدیگر هم باشند. در شکل ۱۵ تفاوت بین K-means , Sparse Coding و Laplacian Sparse Coding نمایش داده شده است .

- تفاوت بین K-means , Sparse Coding و Laplacian Sparse Coding

با افزودن قید حفظ محلی بودن به اهداف sparse coding , روش LSC قادر به حفظ وابستگی دوطرفه در روش sparse coding است . Gao et al.(120) هم بعدتر روش Hypergraph Laplacian Sparse Coding یا به اختصار HLSC را که LSC را توسعه میداد ارائه کرد. روش او برای حالتی بود که شباهات در میان نمونه ها توسط یک hyper graph تعریف میشد. هر دو روش LSC و HLSC به قدرت sparse coding اضافه کردند.

روش دیگری که با استفاده از آن میشود مشکل حساسیت (بیش از حد) را برطرف کرد روش Hierarchial Sparse Coding است که توسط Yu et al. (121) ارائه شد. این روش یک مدل Sparse Coding 2 لایه را که لایه اول هر Patch را بطور جداگانه encode و لایه دوم بصورت مشترک مجموعه از patchها که به یک گروه تعلق داشتند encode میکرد, معرفی کرد. با این کار, این مدل با مدل کردن وابستگی مرتبه بالا (high order dependency) patch ها در همان ناحیه محلی تصویر بهترین استفاده را از ساختار فضای همسایه ای میبرد. علاوه بر آن, این یک روش تمام خودکار برای یادگیری ویژگی ها از سطح پیکسلی است و دیگر بعنوان مثال نیازی به طراحی دستی ویژگی SIFT نیست . Sparse coding سلسله مراتبی (Hierarchical Sparse Coding) در تحقیق دیگری (۱۲۲) برای یادگیری ویژگی های تصاویر بصورت بدون سرپرست مورد استفاده قرار گفته است. این مدل بعدها توسط Zeiler et al.(123) مورد استفاده قرار گرفت.

علاوه بر حساسیت, روش دیگری نیز وجود دارد که برای بهبود الگوریتم ScSPM کاربرد دارد. این روش با در نظر گرفتن خاصیت محلی بودن (locality) سعی در بهبود الگوریتم ScSPM دارد. Yu et al. (114) با توجه در نحوه کار الگوریتم مشاهده کرد که نتایج ScSPM به محلی بودن گرایش دارند یعنی ضرایب غیرصفر معمولا به پایه های نزدیک (nearby bases) اختصاص داده میشوند. به خاطر همین نتایج آنها پیشنهاد اعمال تغییری در ScSPM را دادند که از آن به Local Coordinate Coding یا به اختصار LCC یاد میشود. در این روش که بصورت صریح coding را ترغیب به محلی بودن میکند. آنها همینطور بصورت تئوری نشان دادند که محلی بودن (locality) قادر به ارتقاء و بهبود پراکندگی (sparsity) بوده و sparse coding برای یادگیری تنها در زمانی که codeها محلی باشند سودمند است . بنابر این بهتر است تا داده های مشابه ابعاد غیرصفر در code هایشان داشته باشند. هرچند LCC نسبت به sparse coding کلاسیک از لحاظ محاسباتی برتری دارد اما هنوز نیازمند حل مسئله بهینه سازی L1-norm که زمان گیر است میباشد. به منظور تسریع فرآیند یادگیری یک روش coding عملی بنام Locality Constrained Linear Coding یا به اختصار LLC توسط (۱۱۵) معرفی شد. که میتوان به آن بعنوان یک پیاده سازی سریع از LCC که regularization L1-norm با regularization L2-norm جایگزین شده است دید. شکل ۱۶ مقایسه بین VQ , ScSPM و LLC(115) را نشان میدهد .

- مقایسه بین VQ , ScSPM و LLC[97]

علاوه بر LLC , مدل دیگری نیز وجود دارد که به super vector coding یا به اختصار SVC معروف بوده و sparse coding محلی را تضمین میکند (۱۲۴). با دریافت X , SVC آندسته از مختصاتی که به همسایگی x مربوط هستند را جهت دستیابی به نمایش پراکنده (sparse representation) فعال میکند. SVC یک بسط ساده از VQ است که با گسترش VQ درجهات مماس محلی بدست آمده و به همین دلیل روش coding یکدست تری است .

یک نتیجه جالب توجه که در (۱۲۵) نشان داده شده است, این است که در این مقاله روش averaging stochastic gradient descent (ASGD) با الگوریتم LLC و SVC به منظور افزایش مقیاس پذیری دسته بندی تصاویر در مجموعه داده های عظیم, ترکیب شده و توانست قبل از ظهور معماری های CNN در رقابت ImageNet و کسب بهترین نتایج, نتایج بسیار عالی در این رقابت را کسب کند.

یک روش معروف دیگر بنام Smooth Sparse Coding (SSC) وجود دارد که در (۱۲۶) ارائه شد. این روش با ترکیب شباهت همسایگی و اطلاعات موقتی (temporal information) در sparse coding توانست به کدهایی دست پیدا کند که بجای یک نمونه انفرادی یک همسایگی را نمایش داده و خطای مربع میانگین بازسازی کمتری داشته باشد.

اخیرا He et al.(127) چارجوب یادگیری ویژگی بدون سرپرست جدیدی بنام Deep Sparse Coding یا به اختصار DeepSC را ارائه کردند که Sparse Coding را با استفاده از یک معماری چند لایه بسط داده و توانسته بهترین کارایی را در میان روشهای sparse coding مطرح شده در قبل بدست آورد.

۱-۲-۱۰- بحث

برای مقایسه بین این ۴ دسته از روشهای یادگیری عمیق و بدست آوردن درک درستی از آنها, خلاصه ای از فواید و مشکلات هریک با توجه به خصائص متنوع آنها در جدول شماره ۴ آمده است .

در جدول زیر در کل ۹ خصیصه وجود دارد. که در آن Generalization یا تعمیم پذیری اشاره به این دارد که روش مورد نظر برای رسانه ها (تصویر, صدا و…) و کاربردهای متنوعی مثل تشخیص صدا (speech recognition) , تشخیص تصویر (visual recognition) و … موثر بوده است. یادگیری بدون سرپرست (Unsupervised learning) هم اشاره به توانایی یادگیری خودکار یک مدل عمیق (deep model) بدون تفسیر نظارتی است (without supervisory annotations). یادگیری ویژگی (feature learning) هم توانایی یادگیری خودکار ویژگی ها بر اساس یک مجموعه داده است . آموزش بلادرنگ (real-time training) و پیش بینی بلادرنگ (real-time prediction) هم به ترتیب اشاره به بهره وری(efficiency) یادگیری و فرآینده ای استنتاجی هستند. ادراک بیولوژیکی (Biological understanding) و توجیه نظری (Theoretical justification) هم نشانگر آن هستند که آیا روش مورد نظر دارای شالوده بیولوژیکی یا مبانی نظری است یا خیر.

Invariance یا تغییرناپذیری اشاره به این دارد که آیا روش مورد نظر در مقابل تبدیلاتی (transformations) همانند : چرخش, scale , و translation مقاوم است یا خیر. مجموعه آموزشی کوچک یا Small training set هم اشاره به توانایی یادگیری یک مدل عمیق با استفاده از تنها تعداد کمی نمونه است . این نکته حائز اهمیت است که جدول زیر تنها یافته های کلی فعلی را نمایش داده و صبحتی از فرصتهای آینده و یا نمونه های اختصاصی نمیکند.

| خصائص | CNN | RBM | AutoEncoder | Sparse coding |

| Generalization | بله | بله | بله | بله |

| Unsupervised learning | خیر | بله | بله | بله |

| Feature learning | بله | بله* | بله* | خیر |

| Real-time training | خیر | خیر | بله | بله |

| Real-time prediction | بله | بله | بله | بله |

| Biological understanding | خیر | خیر | خیر | بله |

| Theoretical justification | بله* | بله | بله | بله |

| Invariance | بله* | خیر | خیر | بله |

| Small training set | بله* | بله* | بله | بله |

- توجه: ‘بله’ اشاره به این دارد که دسته دراین خصوصیت بخوبی عمل میکند. در غیر اینصورت با خیر علامت گذاری میشود. ‘بله*’ اشاره به توانایی ابتدایی و یا ضعیف دارد

۱-۲-۱۱-کاربردها و نتایج آنها

یادگیری عمیق (یادگیری عمیق ) بصورت گسترده در زمینه های گوناگونی از بینایی کامپیوتر همانند دسته بندی تصاویر (image classification) , تشخیص اشیاء (object detection) , قطعه بندی معنایی(semantic segmentation) و بازیابی تصاویر(image retrieval) و برآورد ژست انسان (human pose estimation) که فعالیتهایی کلیدی برای درک تصویر اند مورد استفاده قرار گرفته است . در این بخش ما بصورت خلاصه به پیشرفت های یادگیری عمیق در این ۵ ناحیه اشاره میکنیم .

دسته بندی تصاویر (Image classification)

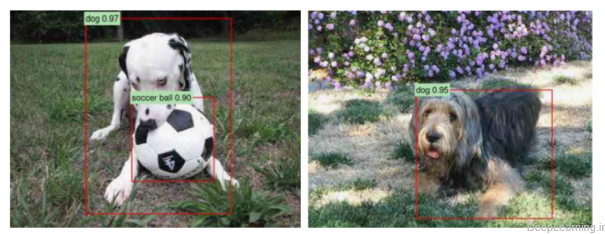

فعالیت دسته بندی تصاویر شامل برچسب گذاری تصاویر ورودی با یک احتمال از حضور دسته خاصی از اشیا بصری میشود. (یعنی آیا یک دسته خاص مثل سگ در یک تصویر وجود دارد یا خیر). این مسئله در شکل ۱۷ نشان داده شده است .

- نمونه ای از دست بندی تصاویر توسط AlexNet

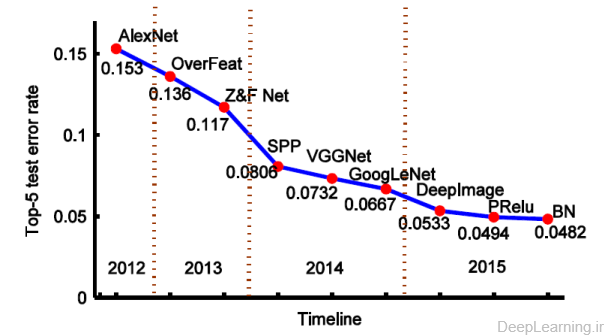

قبل از یادگیری عمیق , شاید محبوب ترین وپراستفاده ترین روشها در زمینه دسته بندی تصاویر (image classification) روشهای مبتنی بر bags of visual words یا به اختصار BoW(128) بودند که ابتدا یک تصویر بصورت یک histogram از کلمات دیداری کوانتیزه[۱۸] شده(یعنی کلمات در قالب اعداد بیان شدند), و سپس بعنوان ورودی این histogram به یک دسته بندی کننده (معمولا یک SVM(129) ) تغذیه میشد. این معماری مبتنی بر آمار بدون ترتیب بود تا بتواند هندسه فضایی (spatial geometry) را در توصیف گرهای BoW ترکیب کند. Lazebnik et al. (117)روش spatial pyramid را با این روش ادغام کرد. که تعداد کلمات بصری درون یک مجموعه از زیر ناحیه های یک تصویر (image sub-regions) را بجای کل ناحیه شمارش میکرد .بعدا این معماری با import مسائل بهینه سازی sparse coding در ایجاد codebookها بیشتر بهبود پیدا کرد (۱۲۵) و توانست بهترین کارایی را در رقابت ImageNet در سال ۲۰۱۰ بدست آورد. Sparse coding یکی از الگوریتم های پایه یادگیری عمیق (یادگیری عمیق ) است و نسبت به الگوریتمهای دستی طراحی شده مثل HOG(130) و LBP (131) بیشتر متمایزکننده(more discriminative) است. روشهای مبتنی بر BoW تنها نگران آمار مرتبه ۰ [۱۹] بوده ( مثل تعداد کلمات بصری) و اطلاعات بسیار زیادی از تصویر را دور میریزند. روش ارائه شده توسط Perronnin et al.(132) بر این مشکل فائق آمده و آمار مرتبه بالاتری با استفاده از Fisher Kernel [135] استخراج کرد و اینطور توانست به نتایج بسیارعالی در رقابت دسته بندی تصاویر در سال ۲۰۱۱ دست یابد. در این فاز, محققان میل به تمرکز بر روی آمار مرتبه بالاتر دارند که هسته اصلی یادگیری عمیق است.Krizhevsky et al. (21) هم با استفاده از آموزش یک شبکه CNN بزرگ بر روی دیتابیس ImageNet (133) و کسب بهترین نتیجه در رقابت ImageNet سال ۲۰۱۲ توانست اثبات کند که شبکه های عصبی کانولوشن علاوه بر تشخیص ارقام دست نویس (۲۰) بخوبی میتوانند دردر حوزه دسته بندی تصاویر هم عمل کنند. این شبکه توانست با کسبtop-5 error rate 15.3%توانست به رتبه اول دست پیدا کرده و فعالیت چشمگیری در حوزه تحقیقات پیرامون شبکه های عصبی کانولوشن ایجاد کند. در شکل ۱۸ نتایج رقابت ImageNet از سال ۲۰۱۲ تابه حال نمایش داده شده است.

- نتایج رقابت ها

OverFeat (134) یک روش چندمقیاسه و پنجره لغزان (multiscale and sliding window) ارائه داد که قادر به یافتن مقیاس بهینه تصویر (optimal scale of the image) و انجام فعالیتهای گوناگون مثل دسته بندی , localization و کشف (detection) در آن واحد بود. این الگوریتم توانست نرخ خطای ۵تای اول (top-5 error rate) را به ۱۳٫۶% کاهش دهد . Zeiler et al. (54) هم تکنیک بصری سازی نوینی را معرفی کرد که باعث ارائه دیدی از کارکرد لایه های میانی شبکه میشد و بوسیله آن مدل جدیدی را تنظیم کرد که توانست AlexNet را شکست داده و به نرخ خطای ۵ تای اول ۱۱٫۷%رسیده و نفر اول رقابت ILSVRC در سال ۲۰۱۳ شود.

ILSVRC 2014 شاهد رشد سریع یادگیری عمیق بود چرا که بیشتر شرکت کنندگان از شبکه های عصبی کانولوشن بعنوان پایه مدلهای خود استفاده کرده بودند. این بار هم پیشرفت چشمگیری در دسته بندی تصاویر اتفاق افتاد و نرخ خطا تقریبا نسبت به ILSVRC2013 نصف شد. مدل SPP-net(46) محدودیت ثابت بودن اندازه تصویر ورودی را از میان برداشت که همین مسئله باعث افزایش دقت در انواع گوناگونی از معماری های شبکه عصبی کانولوشن بدون توجه به طراحی های متفاوت در آنها, شد. شبکه Multiple SPP-net نرخ خطای ۵ تای اول را به ۸٫۰۶% کاهش داده و به مقام سوم در رقابت دسته بندی ILSVRC2014 دست پیدا کرد. علاوه بر بهبودهای صورت گرفته در مدل CNN سنتی, ویژگی دیگری که در میان مدلهای اول (top-performing) مشترک بود, عمیقتر شدن معماری در آنها بود که در GoogLeNet(23) (مقام اول ILSVRC2014 ) وVGGNet(50) (مقام دوم رقابت ILSVRC2014 ) به ترتیب به ۶٫۶۷% و ۷٫۳۲% درصد نرخ خطا دست پیدا کردند کاملا مشهود است .

علیرغم ظرفیت بلقوه مدلهای بزرگ, آنها از مشکلات overfitting و underfitting در زمانهایی که داده آموزشی و یا زمان آموزش کم باشد رنج میبرند. به منظور جلوگیری از این کاستی ها, Wu et al. (44) استراتژی های جدیدی (یعنی تصاویر عمیق (deep image) ) را برای data augmentation و استفاده از تصاویر multi-scale توسعه داد . آنها یک ابررایانه عظیم برای شبکه های عصبی عمیق ساختند و یک الگوریتم موازی بسیار بهینه را توسعه دادند . نتایج دسته بندی تقریبا ۲۰% بهبود نسبت به نتایج قبلی با نرخ خطای ۵ تای اول ۵٫۳۳% را نشان میداد. اخیراHe et al.(135) واحد خطی تحصیح شده پارامتری (Parametric Rectified Linear Unit) را جهت ایجاد واحدهای فعالسازی تصحیح شده سنتی(traditional rectified activation units) ارائه داد و از آن یک روش مقداردهی اولیه (آماده سازی ) (initialization method) قدرتمند (robust) مشتق کرد. این طرح (روش) برای اولین بار سبب رسیدن به نرخ خطای ۵ تای اول ۴٫۹۴% شد و توانست کارایی انسانی (با ۵٫۱% خطا) را پشت سر بگذارد . نتایج مشابه توسط Ioffe et al.(4) بدست امد که در آن او با استفاده از مجموعه ای از شبکه های نرمال شده دسته ای (ensemble of batch normalized networks) توانست به نرخ خطای ۴٫۸% برسد.

تشخیص اشیاء (Object detection)

تشخیص اشیاء (Object detection) فعالیتی متفاوت اما بسیار مرتبط با فعالیت دسته بندی تصاویر است . برای دسته بندی تصاویر, کل تصویر بعنوان ورودی استفاده میشود و برچسب دسته اشیاء درون تصویر تخمین زده میشوند. برای تشخیص اشیاء (object detection) علاوه بر نمایش اطلاعات مربوط به حضور یک کلاس داده شده , همانطور که در شکل ۱۹ نشان داده شده است ما نیازمند این هستیم که مکان نمونه (یا نمونه های) مورد نظر در تصویر را نیز تخمین بزنیم. یک پنجره تشخیص (detection window) در صورتی صحیح در نظر گرفته میشود که محفظه خروجی دور نمونه(outputted bounding box) یافت شده اشتراک زیادی با شی هدف ما داشته باشد ( معمولا بیشتر از ۵۰% باشد)

- شناسایی اشیا توسط RCNN

دیتاست های چالش برانگیز PASCAL VOC , فراگیرترین دیتاست برای ارزیابی تشخیص اشیا (object detection) است. این دیتابیس شامل ۲۰ دسته یا کلاس است . در حین فاز آزمایش یک الگوریتم باید بتواند بدرستی محفظه های شناسایی اشیا (bounding boxes) مربوط به هر کلاس را پیش بینی کند.(یعنی با کشیدن یک مربع یا مستطیل بدور هر شکل موجود در تصویر بگوید هر تصویر به کدام دسته یا کلاس تعلق دارد.) در این بخش ما پیشرفت های اخیر در روش های deep learning برای تشخیص اشیاء را بر اساس دستاوردهای آنها در VOC 2007 و VOC 2012 شرح میدهیم. پیشرفت های مرتبط در جدول ۵ نمایش داده شده اند.

| روش | داده آموزشی | Voc2007 | Voc2012 | |||

| mAP(VGG-Net) | mAp(A/C-Net) | mAP(AlexNet) | mAP(VGG-Net) | |||

| DPM | ۰۷ | ۲۹٫۰۹% | – | – | – | |

| DerecrorNet | ۱۲ | ۳۰٫۱۴% | – | – | ||

| DeepMultiBox | ۱۲ | ۲۹٫۲۲% | – | – | – | |

| RCNN | ۰۷ | ۵۴٫۲% | ۶۲٫۲% | – | – | |

| RCNN+BB | ۰۷ | ۵۸٫۵% | ۶۶٫۰% | – | ||

| RCNN | ۱۲ | – | – | ۴۹٫۶% | ۵۹٫۲% | |

| RCNN+BB | ۱۲ | – | – | ۵۳٫۳% | ۶۲٫۴% | |

| SPP-NET | ۰۷ | ۵۵٫۲% | ۶۰٫۴% | |||

| SPP-NET | ۰۷+۱۲ | ۶۴٫۶% | ||||

| SPP-NET + BB | ۰۷ | ۵۹٫۲% | ۶۳٫۱% | |||

| FCRN | ۰۷ | – | ۶۶٫۹% | – | ۶۵٫۷% | |

| FCRN | ۰۷++۱۲ | – | ۷۰٫۰% | – | ۶۸٫۴% | |

| RPN | ۰۷ | ۵۹٫۹% | ۶۹٫۹% | |||

| RPN | ۱۲ | ۶۷% | ||||

| RPN | ۰۷+۱۲ | – | ۷۳٫۲% | |||

| RPN | ۰۷++۱۲ | – | ۷۰٫۴% | |||

| MR_CNN | ۰۷ | – | ۷۴٫۹% | – | ۶۹٫۱% | |

| MR_CNN | ۱۲ | – | – | – | ۷۰٫۷% | |

| FGS | ۰۷ | ۶۶٫۵% | – | |||

| FGS +BB | ۰۷ | ۶۸٫۵% | ۶۶٫۴% | |||

| NoC | ۰۷+۱۲ | ۶۲٫۹% | ۷۱٫۸% | ۶۷٫۶% | ||

| NoC+BB | ۰۷+۱۲ | ۷۳٫۳% | ۶۸٫۸% | |||

Note: Training data: “۰۷”: VOC07 trainval; “۱۲”: VOC2 trainval; “۰۷þ۱۲”: VOC07

trainval union with VOC12 trainval; “۰۷þþ۱۲”: VOC07 trainval and test union with

VOC12 trainval; BB: bounding box regression; A/C-Net: approaches based on

- AlexNet or Clarifai (54); VGG-Net: approaches based on VGG-Net(50)

سابقا,قبل از فرا رسیدن موج یادگیری عمیق , (DPM)(136) Deformable Part Model موثرترین روش برای تشخیص اشیاء بود. این روش از مدلهای deformable part بهره میبرد و اشیاء را در تمامی مقیاس ها و مکانهای تصویر به شیوه ای جامع تشخیص میداد. بعد از ادغام یکسری روش post-processing مثل bounding box prediction و context rescoring , این مدل توانست به میانگین دقت ۲۹٫۰۹% در مجموعه آزمایش VOC 2007 دست پیدا کند. از آنجایی که روش های یادگیری عمیق (خصوصا روش های مبتنی بر شبکه عصبی کانولوشن) توانسته بودند به کارایی های سطح بالایی در فعالیتهای دسته بندی تصاویر دست پیدا کنند, محققان شروع به استفاده از آنها در حوزه تشخیص اشیاء کردند.

یک روش یادگیری عمیق ابتدایی برای تشخیص اشیا توسط Szegedy et al.(137) ارائه شد. در این مقاله الگوریتمی بنام DetectorNet معرفی شد که آخرین لایه AlexNet(21) را با یک لایه رگراسیون (regression layer) جایگزین میکرد. این الگوریتم توانست مکان اشیاء را بخوبی بدست آورده و به نتایج قابل رقابت با پیشرفته ترین الگوریتم های آن زمان در VOC2007دست پیدا کند. به منظور پشتیبانی از چندین نمونه از یک شی در تصویر , DeepMultiBox(138) نیز یک مدل شبکه عصبی (saliency-inspired neural network) را به نمایش گذاشت.

یک طرح کلی برای سیستم های تشخیص اشیاء موفق فعلی ایجاد منبع بزرگی(large pool) از محفظه های کاندید(candicate boxes) و دسته بندی آنها با استفاده از ویژگی های CNN است . بهترین نمونه این روش, طرح RCNN است که توسط Girshick et al. (31). ارائه شد. این طرح از جستجوی انتخابی (Selective search) (139)برای ایجاد پیشنهاد اشیاء استفاده میکرد و ویژگی ها شبکه عصبی کانولوشن را برای هر پیشنهاد استخراج میکرد. این ویژگی ها سپس به یک دسته بندی کننده (کلاسیفایر) SVM تغذیه شده تا مشخص شود پنجره های کاندید مربوطه شامل شی مورد نظر هستند یا خیر.RCNN ها Benchmark را تا حد بسیار زیادی بهبود دادند و به مدل پایه برای بسیاری از الگوریتم های نویدبخش دراین زمینه تبدیل شدند. (۲۱, ۵۵, ۵۶, ۵۸, ۶۰).

الگوریتم های مشتق شده از RCNN ها بطور کلی به دو دسته تقسیم میشوند. دسته اول بدنبال تسریع فرآیند آموزش و آزمایش است . هرچند RCNN دقت بسیار عالی در تشخیص اشیاء دارد اما بواسطه اینکه بطور جداگانه هر پیشنهاد شی ای را انتخاب و بعد پردازش میکند از لحاظ پردازشی بسیار سنگین است . در نتیجه بعضی از الگوریتم های معروف که بدنبال بهینگی این مدل بودند پدیدار شدند. الگوریتمهای SPP-net(46) FRCN(55), RPN(56), YOLO(140) , و … از این دسته اند. دسته دوم عمدتا بدنبال بهبود دقت RCNN ها هستند. کارایی طرح “recognition using regions” یا تشخیص از طریق ناحیه ها بشدت به کیفیت فرضیه شی وابسته است . در حال حاضر, الگوریتم های پیشنهاد شی زیادی وجود دارد که objectness(141) ,selective search(139) , object proposals (142) category-independent , BING (143) و edge boxes(144) et al نمونه هایی از این دست هستند.

این طرح ها و روشها بصورت جامع در (۱۴۵) مورد ارزیابی قرار گرفتند. اگرچه این روش ها در پیدا کردن مکانهای تقریبی اشیاء خوب هستند اما معمولا قادر به مکان یابی دقیق تمام شی از طریق یک محفظه تنگ (tight bounding box) نیستند. که همین مسئله باعث ایجاد بزرگترین منبع خطای تشخیص در آنها شده است. (۱۴۶, ۱۴۷) بنابر این برای حل این مشکل روشهای زیادی بوجود آمدند تا به تصحیح این مکان یابی ضعیف بپردازند.

یک جهت مهم در این روش ها ترکیب آنها با روش های قطعه بندی معنایی (semantic segmentation) است .(۵۸, ۶۰, ۱۴۸) بعنوان مثال روش SDS پیشنهاد شده توسط Hariharan et al.(60) از قطعه بندی (segmentaion) برای حذف (mask-out) پس زمینه در یک عملیات تشخیص استفاده میکند که این کار باعث بهبود کارایی در تشخیص اشیا ( از ۴۹٫۶% به ۵۰٫۷% بدون رگراسیون محفظه تشخیص (bounding box regression)) شد. از طرف دیگر روش UDS(148) تشخیص اشیاء و فرایند قطعه بندی معنایی را در یک چارجوب با اجبار ثبات آنها و ادغام اطلاعات متنی ,باهم ترکیب کرد. این مدل کارایی خوبی در هر دو فعالیت از خود نشان داد. کارهای مشابه مثل segDeepM که توسط Zhu et al.(58) ارائه شد و MR_CNN در(۵۷) هم که از قطعه بندی به همراه مدارک اضافی برای افزایش دقت در تشخیص اشیاء استفاده کردند نیز وجود دارند. روشهای دیگری هم وجود دارند که سعی میکنند بصورت های دیگری به مکان یابی دقیقی دست پیدا کنند .بعنوان مثال FGS(59) از طریق ۲ روش به حل این مشکل پرداخته است . ابتدا یک الگوریتم سرچ بهینه (fine-grained) برای بهینه سازی تکراری مکان توسعه داد و سپس یک دسته بندی کننده (کلاسیفایر) شبکه عصبی کانولوشن را به همراه یک هدف SVM ساخت یافته (structured SVM objective) برای بالانس کردن بین دسته بندی و مکان یابی آموزش داد. ترکیب این روشها کارایی امیدوارکننده ای در دیتاست های چالش برانگیز از خود نشان داده است.

گذشته از تلاشهای صورت گرفته در مکان یابی اشیاء , چارجوب NoC در (۱۴۹) تلاش میکند تا تلاشها را بسمت دسته بندی اشیاء تکامل دهد. بجای شبکه پرسپترون چند لایه این مقاله ساختارهای NoC مختلفی را جهت پیاده سازی دسته بندی کننده اشیاء امتحان کرده است.

جمع آوری مقدار زیادی از برچسب های سطح تصویر نسبت به جمع آوری داده تشخیص و بعد برچسب گذاری آن با استفاده از محفظه های شناسایی (bounding box) دقیق بسیار ارزانتر و ساده تر است . بنابر این یک چالش اصلی در مقیاس پذیری (scaling) تشخیص اشیا, دشواری بدست آوردن تصاویر برچسب گذاری شده برای تعداد زیادی دسته است .(۱۵۰, ۱۵۱) . Hoffman et al.(151) الگوریتم Deep Detection Adaption (DDA) را برای یادگیری تفاوت بین دسته بندی تصاویر و تشخیص اشیاء, با تبدیل دسته بندی کننده های(کلاسیفایرها) دسته ها به detector ها بدون داده های حاشیه نویسی شده با محفظه شناسایی (bounding box annotated data) ارائه داد. این روش پتانسیل تشخیص هزاران دسته که فاقد تفسیر های (حاشیه نویسی)محفظه شناسایی هستند را دارد.

دو روش نوید بخش و مقیاس پذیر (۱۵۲)ConceptLeaner و BabyLearning(153) هستند. هردو اینها قادر به یادگیری دقیق مفهوم یابها (concept detectors) بدون حاشیه نویشی فراوان مفاهیم بصری هستند. از آنجایی که جمع آوری تصاویر برچسب گذاری شده ضعیف ارزان است, ConceptLeaner یک الگوریتم max-margin hard instance learning را جهت کشف مفاهیم بصری از مجموعه تصاویر برچسب گذاری شده نویزدار توسعه داد. در نتیجه, این روش پنانسیل یادگیری مفاهیم از وب را بصورت مستقیم دارد. از طرف دیگر روش Baby- Learning(153) تعامل یک نوزاد با دنیای فیزیکی را شبیه سازی کرده و میتواند نتایج قابل مقایسه ای را با روش های مبتنی بر آموزش کامل به همراه تعداد کمی نمونه برای هر دسته از اشیاء و تعداد زیادی ویدئو بدون برچسب آنلاین بدست آورد. در جدول شماره ۴ علاوه بر خود الگوریتم , چندین فاکتور که میتوانند باعث بهبود کارایی شوند نشان داده شده است ( ۱)مجموعه آموزشی بزرگ ۲)مدل پایه عمیقتر ۳) رگراسیون محفظه شناسایی )

بازیابی تصاویر (Image retrieval)

بازیابی تصاویر بدنبال یافتن تصاویری است که شامل یک شی یا صحنه مشابه با تصویر مورد جستجو, همانند آنچه در شکل ۲۰ نمایش داده شده است, باشند. موفقیت AlexNet(21) اینرا به ذهن متبادر کرد که ویژگی های نمایان شده در لایه های بالایی یک شبکه عصبی کانولوشن که برای دسته بندی تصاویر آموزش دیده است, را میتوان به عنوان توصیفگر خوبی برای دسته بندی تصاویر مورد استفاده قرار داد. مطالعات بسیار زیادی با همین انگیزه, از شبکه های عصبی کانولوشن برای فعالیت های بازیابی تصاویر استفاده کردند. [review] این مطالعات به نتایج قابل رقابت در قیاس با روش های سنتی همانند VLAD و Fisher Vector دست پیدا کردند. در پاراگراف بعدی ما ایده اصلی موجود در این روشهای مبتنی بر شبکه عصبی کانولوشن را معرفی میکنیم .

Gong et al.(154) با الهام از Spatial Pyramid Matching ایده نوعی reverse SPM را ارائه کرد که patch ها را در مقیاس های چندگانه با شروع از کل تصویر و سپس با ادغام (pool) هر مقیاس بدون توجه به اطلاعات مکانی آن ,استخراج میکرد. سپس پاسخهای patch محلی را با استفاده از encoding VLAD در مقیاس بهتری تجمیع میکرد. طبیعت بدون ترتیب VLAD به ایجاد نمود بدون تغییر بهتری کمک میکرد.سپس مقادیر عمیق سراسری اصلی با ویژگی های VLAD برای رسیدن به مقیاس های بهتر متصل شده تا تشکیل یک نمایش جدید از تصویر را بدهد.

Razavian et al.(155) [165] از ویژگی های استخراج شده از شبکه OverFeat بعنوان یک نمود تصویری کلی برای استفاده در فعالیت های مختلف مربوط به حوزه بینایی کامپیوتر استفاده کرد. او ابتدا مجموعه آموزشی را با استفاده از نمونه های چرخانده شده و crop شده تغییر داد . سپس برای هر تصویر چندیدن Subpatch با اندازه های مختلف از مکان های مختلف استخراج کرد. هر sub-patch برای نمود CNN خود محاسبه میشود. فاصله بین تصویر اصلی و تصویر جستجو شده برابر میانگین فاصله هر subpatch از تصویر اصلی قرار داده میشود. با توجه به موفقیت های اخیر که روش های یادگیری عمیق بدست آورده اند, تحقیق انجام شده در (۵۱)بدنبال ارزیابی این است که آیا یادگیری عمیق میتواند فاصله معنایی در بازیابی تصاویر مبتنی بر محتوا (content-based image retrieval (CBIR))را پر کند یا خیر. نتایج نوید بخش آنها نشان میدهد که مدلهای شبکه عصبی کانولوشن از پیش آموزش دیده بر روی دیتاست های عظیم را میتوان بصورت مستقیم برای استخراج ویژگی در فعالیت های CBIR جدید مورد استفاده قرار داد.

اگر از این روش به منظور feature representation در زمینه جدیدی استفاده شود, مشخص شده است که similarity learning باعث بهبود کارایی بازیابی میشود. در ادامه با حفظ مدلهای عمیق با یک هدف similarity learning و یا دسته بندی در زمینه جدید میتوان بطور قابل ملاحظه ای دقت را نیز بهبود داد. روش متفاوت دیگری در (۱۵۶) ارائه شده است که در آن,ابتدا patchهای تصویری شی مانند با استفاده از یک شی یاب کلی (general object detector) استخراج شده و سپس یک ویژگی CNN از هر object patch با مدل از پیش آموزش دیده AlexNet استخراج میشود.با آزمایشات فراوانی که محققان در این تحقیق خود انجام دادند نهایتا به این نتیجه رسیدند که روش آنها قادر به کسب بهبود قابل توجهی در دقت با همان میزان هزینه فضایی(space consumption) و هزینه زمانی میباشد.

در آخر بدون استفاده از sliding windows و یا multiple-scale patches Babenko et al.(157) بر روی توصیفگرهای جامعی که تمام تصویر را با استفاده از یک مدل CNN به یک بردارنگاشت میکرد تمرکز کرد. مشخص شد که بهترین کارایی نه در لایه بالایی شبکه بلکه در لایه ای که دو سطح پایین تر از خروجی بود مشاهده شده است. نتیجه مهمی که در اینجا وجود دارد این است که تاثیر سوء PCA بر روی کارایی CNN کمتراز VLAD و یا Fisher Vector ها است . بنابر این کم حجم سازی PCA (PCA compressing) برای ویژگی های CNN بهتر عمل میکند. در جدول ۶ نتایج بازیابی تصاویر در چند دیتاست عمومی نشان داده شده است.

| روشها | Holidays | Paris6K | Oxford5K | UKB |

| Babenko et al | ۷۴٫۷ | – | ۵۵٫۷ | ۳٫۴۳ |

| Sun et al | ۷۹٫۰ | – | – | ۳٫۶۱ |

| Gong et al | ۸۰٫۲ | – | – | – |

| Razavian et al | ۸۴٫۳ | ۷۹٫۵۰ | ۶۸٫۰ | –(۹۱٫۱) |

| Wan et al | – | ۹۴٫۷ | ۷۸٫۳ | – |

- نتایج

مشکل جالب دیگری که در ویژگی های CNN وجود دارد این است که کدام لایه بیشترین اثر را در کارایی نهایی دارد؟ بعضی از روشها ویژگی ها را در لایه تماما متصل دوم استخراج میکنند (۱۵۴, ۱۵۶)

در حالی که بعضی دیگر از روش ها , از لایه تماما متصل اول در مدل CNN خود برای image representation بهره میبرند. (۱۵۵, ۱۵۷) علاوه بر اینها, این انتخابها ممکن است برای دیتاست های مختلف هم تغییر کند(۵۱)بنابر این ما فکر میکنیم تحقیقات بیشتر در زمینه ویژگی های هر لایه هنوز یک مسئله حل نشده (open problem)باقی مانده است .

Semantic Segmentation

طی نیم سال اخیر تعداد زیادی از تحقیقات حول فعالیت قطعه بندی معنایی (semantic segmentation) متمرکز شده اند و نتایج آنها نوید دهنده پیشرفتهای قابل ملاحظه ای هستند.[review] دلیل اصلی موفقیت آنها, استفاده از مدلهای CNN ناشی میشود که قادر به مقابله با تخمین های سطح پیکسلی با استفاده از شبکه های از پیش آموزش دیده بر روی دیتاست های با مقیاس بزرگ هستند.Semantic segmentation با دسته بندی در سطح تصویر (image-level classification) و تشخیص سطح شی (object –level detection) متفاوت بوده و نیازمند mask های خروجی است که دارای توزیع مکانی دو بعدی باشند .

برای semantic segentation , پیشرفتهای اخیر در روش های مبتنی بر CNN را میتوان بصورت زیر خلاصه کرد :

- Detection-based segmentation.

- FCN-CRFs based segmentation.

- Weakly supervised annotations.

Detection-based segmentation

این روش تصاویر را بر اساس پنجره های کاندید خروجی حاصله از فاز تشخیص شی قطعه بندی میکند. [review]

RCNN (31) و SDS(60) ابتدا پیشنهادهایی برای هر ناحیه (region proposals) را برای تشخیص شی تولید کرده و سپس از روش های اضافی برای قطعه بندی ناحیه و انتساب پیکسلها به برچسب کلاس از فاز تشخیص استفاده میکردند. Hariharan et al.(158) روشی را بر مبنای SDS(60) ارائه کرد که در آن hypercolumn در هر پیکسل را بعنوان برداری از فعالسازی ها در نظر گرفت و به این وسیله به بهبود عظیمی دست پیدا کرد. یک مشکل قطعه بندی بر اساس تشخیص, هزینه اضافی زیاد بابت تشخیص اشیاء است. Dai et al.(159) بدون استخراج نواحی از تصاویر خام ,یک روش convolutional feature masking (CFM) را به منظور استخراج پیشنهادها بصورت مستقیم از feature mapها طراحی کرد .از آنجایی که feature map های کانولوشنی تنها یکبار نیازمند محاسبه شدن هستند, روش بهینه و کارامدی است هرچند که خطاهای ایجاد شده توسط پیشنهادها و ]فاز[ تشخیص شی معمولا در مرحله قطعه بندی پخش میشوند.

FCN-CRFs based segmentation.

دراین روش که استراتژی محبوبی شده و پایه ای برای انجام semantic segmentation شده است با جایگزینی لایه های تماما متصل با لایه های کانولوشنی بیشتر, به قطعه بندی معنایی پرداخته میشود. (۴۸, ۱۶۰) . Long et al. (48) معماری نوینی را تعریف کرد که در آن اطلاعات معنایی از یک لایه جامع عمیق به همراه اطلاعات ظاهری از یک لایه کم عمق مناسب برای تولید قطعه بندی های دقیق و با جزییات استفاده کرد. DeepLab (۱۶۰)مدل FCN مشابه ای را ارئه کرد که علاوه بر موارد فوق, از نیروی conditional random fields (CRFs) نیز در FCN برای بازیابی دقیق مرزها استفاده کرد . , Lin et al. (161) به جای استفاده از CRF ها بجای یک مرحله post-processing بطور مشترک FCN و CRF را بوسیله آموزش قطعه به قطعه , آموزش داد. به همین شکل (۱۶۲)نیز CRF ها را به صورت یک recurrent neural network(RNN) تدبل کرد که میشد آنرا به عنوان بخشی از یک مدل FCN اضافه کرد.

Weakly supervised annotations.

علاوه بر پیشرفت هایی صورت گرفته در مدلهای قطعه بندی, بعضی کارها بر روی قطعه بندی با سرپرست ضعیف (weakly supervised segmentation) تمرکز کرده اند. Papandreou et al.(163) قطعه بندی چالش برانگیزتری را با داده آموزشی بطور ضعیف حاشیه نویسی شده (weakly annotated training data) مثل محفظه های شناسایی (bounding boxes) و یا برچسب های سطح تصویر ( image-level labels) مورد مطالعه قرار داد.به همین شکل روش BoxSup(164) از حاشیه نویسی های محفظه شناسایی (bounding box annotations) جهت تخمین ماسکهای قطعه بندی (segmentation masks) که برای بروز آوری شبکه بصورت تکراری مورد استفاده قرار میگرفتند, بهره برد. این کارها نشان داند که کارایی عالی در زمان ترکیب تعداد کمی از تصاویر حاشیه نویسی شده در سطح پیکسل با تعداد زیادی از تصاویر حاشیه نویسی شده با محفظه شناسایی بدست می آید.

خصوصیات اصلی روش های بالا و مقایسه بین نتایج آنها در PASCAL VOC 2012 درجدول ۷ نمایش داده شده است .

| روشها | آموزش | Val2012 | Test2012 | توضیحات |

| SDS | VOC extra | ۵۳٫۹ | ۵۱٫۶ | Region proposals on input images |

| CFM | VOC extra | ۶۰٫۹ | ۶۱٫۸ | Region proposals on feature maps |

| FCN-8s | VOC extra | – | ۶۲٫۲ | One model; three strides |

| Hypercolumn | VOC extra | ۵۹٫۰ | ۶۲٫۶ | Region proposals on input images |

| DeepLab | VOC extra | ۶۳٫۷ | ۶۶٫۴ | One model; one stride |

| DeepLab-MSc-LargeFOV | VOC extra | ۶۸٫۸ | ۷۱٫۶ | Multi-scale; Field of view |

| Piecewise-DCRFs | VOC extra | ۷۰٫۳ | ۷۰٫۷ | ۳ scales of image; 5 models |

| CRF-RNN | VOC extra | ۶۹٫۶ | ۷۲٫۰ | Recurrent Neural Networks |

| BoxSup | VOC extraþCOCO | ۶۸٫۲ | ۷۱٫۰ | Weakly supervised annotations |

| Cross-Joint | VOC extraþCOCO | ۷۱٫۷ | ۷۳٫۹ | Weakly supervised annotations |

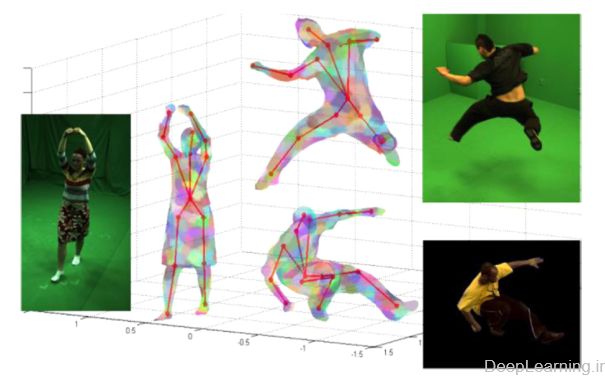

برآورد ژست انسانی (Human pose estimation)

Human pose estimation همانطور که در شکل ۲۱ نشان داده شده است ,بدنبال تقریب محل مفاصل انسان در تصاویر و یا دنباله ای از تصاویر است. تقریب این مسئله برای بازه گسترده ای از کاربردها بسیار حائز اهمیت است . بعنوان مثال میتوان به نظارت ویدئویی (video surveilance), تحلیل رفتار انسان, تعامل انسان و رایانه (human-computer interation (HCI)), بعنوان نمونه هایی از این دست اشاره کرد. این مسئله اخیرا بشدت مورد مطالعه قرار گرفته است [review] . اما این فعالیت بواسطه تغییرات بسیار زیاد در ظاهر افراد , پس زمینه های پیچیده و همینطور عوامل مخل دیگر مثل , نور (illumination), زاویه دید, مقیاس (scale) و … کار بسیار چالش برانگیزی است . در این بخش ما بطور عمده روش های یادگیری عمیق را برای تقریب مفصلبندی انسان از طریق تصاویر ثابت بطور خلاصه مورد بحث قرار میدهیم هرچند این طرح ها را میتوان با ویژگی های حرکتی به منظور بهبوبد کارایی آنها در ویدئوها نیز مورد استفاده قرار داد. (۱۶۵-۱۶۷).

بطور معمول, تقریب ژست انسان, شامل چندین مشکل مثل تشخیص افراد در تصاویر, کشف و توصیف بخش های مختلف بدن انسان و مدل سازی پیکربندی مکانی آنها میشود. قبل از یادگیری عمیق بهترین روشهای تقریب ژست انسان, مبتنی بر کشف کننده های اعضای بدن بودند. یعنی ابتدا اعضای بدن انسان را کشف و بعد توصیف کرده و سپس روابط متنی(contextual) بین اعضای محلی را اعمال میکردند. . یک نمونه از این روش ها , ساختارهای مصور یا pictorial structures(168) است که از مدل درختی برای دریافت (capture) روابط هندسی بین بخشهای متصل بهم بهره برده و توسط روش های مبتنی بر بخش معروف مختلفی توسعه داده شده است . (۱۶۹-۱۷۲).

از آنجایی که الگوریتم های یادگیری عمیق قادر به فراگیری ویژگی های سطح بالا اند و به همین دلیل در مقابل تغییرات المان های مخل محیطی مقاوم بوده و همچنین به موفقیت های زیادی در حوزه های مختلف بینایی کامپیوتر دست پیدا کرده اند, اخیر بشدت مورد توجه محققان برای استفاده در این حوزه قرار گرفته اند.

ما کارایی مربوط به الگوریتم های یادگیری عمیق را در دو دیتاست معروف Frames Labeled In Cinema (FLIC) (173) و Leeds Sports Pose (LSP)(174) بصورت خلاصه قرار دادیم . FLIC شامل ۳۹۸۷ تصویر آموزشی و ۱۰۱۶ تصویر جهت آزمایش است که از فیلم های محبوب هالیوودی که شامل افراد مختلف در حالات متنوع بوده بدست آمده است.این تصاویر با برچسب هایی برای بخش بالایی بدن حاشیه نویسی شده اند. LSP و extension آن شامل ۱۱۰۰۰ تصویر آموزشی و ۱۰۰۰ تصویر جهت آزمایش از ورزشکاران که از سایت Flickr به همراه حاشیه نویسی ۱۴ مفصل بدن بوده میباشد. دو ملاک ارزیابی که بصورت گسترده مورد قبول واقع شده است درصد اعضای درست یا Percentage of Correct Parts (PCP)(175) و درصد مفصل های تشخیص داده شده یا Percent of Detected Joins(PDJ) (173) میباشد که ملاک اول نرخ تشخیص صحیح اعضای بدن را اندازه گرفته و ملاک دوم نرخ مفاصل تشخیص داده شده را مشخص میکند. در زیر, جدول شماره ۸ مقایسه ای بین روش های گوناگون یادگیری عمیق بر روی دیتاست FLIC با فاصله نرمال شده ۰٫۰۵ را نشان میدهدو جدول ۹ مقایسه PCP بر روی دیتاست LSP را نشان میدهد.

| PDJ(PCK) | سر | سرشانه | آرنج | مچ |

| Jain et al | – | ۴۲٫۶ | ۲۴٫۱ | ۲۲٫۳ |

| DeepPose | – | – | ۲۵٫۲ | ۲۶٫۴ |

| Chen et al | – | – | ۳۶٫۵ | ۴۱٫۲ |

| DS-CNN | – | – | ۳۰٫۵ | ۳۶٫۵ |

| Tompson et al | ۹۰٫۷ | ۷۰٫۴ | ۵۰٫۲ | ۵۵٫۴ |

| Tompson et al | ۹۲٫۶ | ۷۳ | ۵۷٫۱ | ۶۰٫۴ |

| Torso | سر | بازوها-بالا | بازوها پایین | پاها بالا | پاها پایین | میانگین | |

| Quyang et al | ۸۵٫۸ | ۸۳٫۱ | ۶۳٫۳ | ۴۶٫۶ | ۷۶٫۵ | ۷۲٫۲ | ۶۸٫۶ |

| DeepPose | – | – | ۵۶ | ۳۸ | ۷۷ | ۷۱ | – |

| Chen et al | ۹۲٫۷ | ۸۷٫۸ | ۶۹٫۲ | ۵۵٫۴ | ۸۲٫۹ | ۷۷ | ۷۵ |

| DS-CNN | ۹۸ | ۸۵ | ۸۰ | ۶۳ | ۹۰ | ۸۸ | ۸۴ |

درکل, روشهای یادگیری عمیق در تقریب ژست انسان, را میتوان بر اساس نحوه مدیریت تصاویر ورودی به پردازش جامع و یا پردازش مبتنی بر بخش دسته بندی کرد.

روش های پردازش جامع میل به تکمیل وظایفشان در یک قالب سراسری دارند. و مدلی را بصورت صریح برای هر بخش مجزا و روابط مکانی آنها مشخص نمیکنند. یک نمونه از این مدل , DeepPose است که توسط Toshev et al.(176) ارائه شده است. این مدل روش تقریب ژست انسان را بصورت مشکل رگراسیون مشترک فرموله کرده و بصورت صریح مدل گرافیکی و یا بخش یابی را برای تقریب ژست انسانی مشخص نمیکند.

بطور خاص, این مدل از معماری دو لایه ای بهره میبرد که در آن لایه اول به رفع ابهام بین بخش های بدن بصورت جامع پرداخته و تقریب ژست اولیه را ایجاد میکند. لایه دوم هم نقاط مفاصل را برای تقریب بهبود میدهد. این مدل به پیشرفتهایی در چندین دیتاست چالش برانگیز دست یافته است. اما روشهای مبتنی بر جامع بودن(holistic based methods) از بی دقتی در نواحی با دقت بالا رنج میبرند چرا که یادگیری رگراسیون بردارهای ژست پیچیده مستقیم از تصاویر دشوار است .

روش های پردازشی مبتنی بر بخش (part based methods) پیشنهاد میکنند تا بخشهای بدن بصورت انفرادی یافت شده و سپس توسط یک مدل گرافیکی با اطلاعات مکانی ترکیب شود. , Chen et al.(177) بجای آموزش شبکه با استفاده از کل تصویر, از part patch های محلی و background patch ها برای آموزش DCNN استفاده کرد تا احتمالات شرطی حضور یک بخش و ارتباطات مکانی آنرا فراگیرد.

با ترکیب با مدلهای گرافیکی , این الگوریتم توانست کارایی خوبی بدست بیاورد. علاوه بر آن , Jain et al. (178)چندین شبکه عصبی کانولوشن کوچک را به منظور انجام دسته بندی اعضای بدن دودویی مستقل آموزش داد و بعد از آن از مدل مکانی ضعیف سطح بالاتر (higher level weak spatial model) برای حذف خطوط قوی و اعمال یکدستی ژست سراسری استفاده کرد. به همین شکل Tompson et al.(179) معماری های ConvNet چندن رزولوشنه طراحی کرد تا heat-map رگراسیون احتمال برای هر بخش از بدن را بدست اورد که بعد از ان مدل گرافیکی ضمنی برای سازگاری بیشتر مفصل استفاده شود.

این مدل بعدها در (۱۸۰)بیشتر بسط داده شد و در آن عنوان شد که لایه های pooling در شبکه های عصبی کانولوشن باعث محدود شدن دقت مکان یابی مکانی شده و به همین علت برای بازیابی افت دقت رخ داده در فرایند pooling تلاش کردند. آنها بطور ویژه روش آمده در (۱۷۹) را با اضافه کردن یک لایه Dropout مکانی بادقت طراحی شده و ارائه یک شبکه نوین که از ویژگی های کانولوشنی لایه پنهان جهت بهبود دقت locality مکانی(spatial locality) دوباره استفاده میکرد بهبود دادند.

روشهایی نیز وجود دارند که پیشنهاد میکنند به منظور دستیابی به تقریب ژست انسان دقیقتر هم ظاهر بخش محلی و هم دید جامع بخشها با هم ترکیب شوند. بعنوان مثال Ouyang et al.(181) از Deep Belief Network(DBN) یک مدل عمیق چند منبعی را مشتق کرد که تلاش میکرد تا از سه منبع اطلاعات مفاصل انسانی. یعنی ترکیب نوع, امتیاز ظاهری و تغیرشکل بهره برده و با ترکیب نمایه های سطح بالای آنها الگوهای مفصلی مرتبه بالا انسان را فرابگیرد. از طرف دیگر, Fan et al.(182) یک شبکه عصبی کانولوشنی دو منبعی (DS-CNN) را ارائه کرد تا دید جامع و جزئی را در شبکه عصبی کانولوشن ادغام کند.این شبکه part patch ها و body patch ها را بعنوان ورودی دریافت کرده تا اطلاعات متنی و محلی را برای تقریب ژست دقیقتر با هم ترکیب کند.

از آنجایی که بیشتر روشها تمایل به طراحی معماری های feed-forward جدید دارند, Carreira et al. [211] (183)یک مدل خود تصحیح کن (self-correctng) بنام Iterative Error Feedback(IEF) را ارائه کرد که قادر به دربرگرفتن ساختار غنی در هر دو فضای ورودی و خرجی با استفاده از feedback بالا به پایین میباشد. این مدل نتایج امیدوارکننده ای از خود به نمایش گذاشته است.

۱-۲-۱۲-گرایشات و چالشها (Trends and challenges)

درک تئوریک (Theoretical understanding)